معمای برتری کوانتومی؛ آیا ادعای گوگل در برابر بررسیها دوام میآورد؟

گوگل در اکتبر اعلام کرد پردازندهی کوانتومیاش موفق شده است وظیفهای پردازشی را انجام دهد که برای کامپیوترهای معمولی تقریبا ناممکن بهنظر میرسد. چنین ادعایی بهسرعت با واکنش دیگر فعالان دنیای رایانش کوانتومی، خصوصا IBM روبهرو شد که البته غول موتور جستوجو برای آن آماده بود. درادامهی این مطلب زومیت ، مفاهیم ادعای برتری کوانتومی را بررسی و پیچیدگیهای دنیای کوانتوم را شرح میدهیم. اصطلاحات علمی و تخصصی متعدد استفادهشده در مقالهی حاضر به دقت مطالعهی زیاد علاقهمندان نیاز دارد.

اگر رایانش کوانتومی بخواهد از فضای تجربی به صنعتی قابلقبول و کاربردی تبدیل شود، در قدم اول باید یک مدل کسبوکاری معقول و پایدار داشته باشد. بهبیان دیگر کسبوکارها زمانی در ماشینها، فناوریها و خدمات سرمایهگذاری میکنند، که دستاوردهای مربوطه به مرحلهای از قابلیت اعتماد و پایداری رسیده باشند. آنها طبق انتظار کاربران و کارمندان خود عمل میکنند. دراینمیان اگر هر ماشینی ادعای برتری عملیاتی داشته باشد، کسبوکارها انتظار دارند که برتری مذکور را بهصورت پایدار ادامه دهد. درواقع آنها میخواهند سرمایهگذاریهایشان به تغییرهای عینی و سریع در جهان بینجامد. در دنیای کنونی، برتری کوتاهمدت یک ماشین بر دیگری که حتی زمانی کوتاهتر از چرخهی عمر یک محصول دارد، هیچگاه بهعنوان برتری شناخته نمیشود. در دنیای واقعی، برتری زمانی رخ میدهد که ادامهدار باشد.

گروهی از محققان گوگل در مقالهای که شمارهی اکتبر ژورنال Nature چاپ شد، نوشتند:

آزمایشهای ما به برتری کوانتومی دست یافتند. دستاوردی که در مسیر رایانش کوانتومی در مقیاس کامل قرار دارد. نظریهی تکاملیافتهی چرچ-تورینگ ادعا میکند که هر نوع رایانش معقول، قابل شبیهسازی با بازدهی بالا توسط یک ماشین تورینگ خواهد بود. آزمایشهای ما نشان میدهد که احتمالا یک مدل از رایانش امروز وجود دارد که ادعای مذکور را نقض میکند.

گروه تحقیقاتی بالا علاوه بر دانشمندانی از گوگل، شامل اعضایی از مرکز تحقیقات Ames ناسا، دانشگاه ماساچوست امهرست و آزمایشگاه ملی اوک ریج نیز بود.

داستان ادعای برتری کوانتومی

ادعای گوگل و اعتراض و ادعاهایی که بعدا از سوی IBM مطرح شد، زنجیرهای طولانی را در مقالههای رسانهای بههمراه داشت. IBM میگفت گوگل فرضیههای اولیهی آزمایش را بهصورت صحیح تنظیم نکرده است و نمیتوان ادعای برتری را کامل دانست. درمقابل مدیران متعدد گوگل و حتی ساندار پیچای هم تأکیدی جدی روی اهمیت دستاورد اولیهی خود داشتند.

با وجود تعدد ادعاها دربارهی برتری کوانتومی، معماری پایه و ساختار رایانش کوانتومی در تعاریف متعدد به هم شباهت دارد. البته رویکردهای فنی متعددی را میتوان برای انجام فعالیت پردازش بهکمک ذرههای زیراتمی بهکار گرفت و معماری Sycamore گوگل یکی از آنها محسوب میشود. در تعریف کلی، هر روشی که از رفتار غیرقابل پیشبینی و غیرمعمول ذرههایی در سطح کوانتوم برای انجام محاسبات با احتمال دقت بالا و شانس معقول تکرار استفاده کند، بهنام سیستم رایانش کوانتومی شناخته میشود.

اگر استفاده از ساختارهای کوانتومی برای رایانش با موفقیت همراه شود، کامپیوتر حاصل سرعتی چندین برابر هر کامپیوتر کلاسیک خواهد داشت که برپایهی ترانزیستورها و نیمههادیها عمل میکند. برتری کوانتومی، آنطورکه گوگل ادعا کرده و یکی از پیشگامان رایانش کوانتومی رد کرد، زمانی رخ میدهد که با هیچ روش قابل اطمینانی حتی با استفاده از خود رایانش کوانتومی هم نتوان برتری سرعت رایانش کوانتومی را نسبت به کامپیوترهای کلاسیک اندازهگیری کرد. ادعای گوگل با مقایسهی عددهای ۲۰۰ ثانیه و بیش از ۱۰ هزار سال را برای تفاوت رایانش کلاسیک و کوانتومی مطرح میکند.

پردازندهی سیکامور محصول رویکردی است که با هدف بهرهبرداری از رفتارهای منحصربهفرد ذرات باردار الکتریکی بهنام فرمیون اجرا شد. فرایندی که در اصطلاحات علمی بهنام درهمتنیدگی (Entanglement) شناخته میشود. مشهورترین ذرهی فرمیون، الکترون است که ذرهی زیراتمی درگیر در تمامی سیستمهای دیجیتال محسوب میشود. در سیستمهای الکترونیکی مرسوم، مدیریت دنبالههای طولانی اطلاعات، به زمان نیاز دارد. در سیستمهای کوانتومی میتوان همین رخداد را فورا انجام داد. فرایند کوانتومی نیز در اکثر مواقع نرخ موفقیت بیشتری نسبت به نرخ شکست دارد.

وقتی الکترونها وارد فاز درهمتنیدگی شوند، خصوصیات مشترک را بهصورت بسیار نزدیک با هم به اشتراک میگذارند. درنتیجه وقتی فاز یک الکترون تغییر کند، همان رخداد برای تمامی الکترونهای درهمتنیده اتفاق میافتد. درواقع این عملکرد، همان معنای درهمتنیدگی محسوب میشود. بهعلاوه با اضافه شدن هر الکترون درهمتنیده به مجموعهی موجود، تعداد موقعیتهای احتمالی که فاز مشترک به خود اختصاص میدهد، بهصورت نمایی افزایش مییابد. درنهایت کیوبیتها در یک مجموعهی درهمتنیده بهجای نشان دادن تنها دو حالت صفر و یک، تعداد حالتهایی تا دو به توان مجموع تعداد کیوبیتهای درهمتنیده داشته باشد.

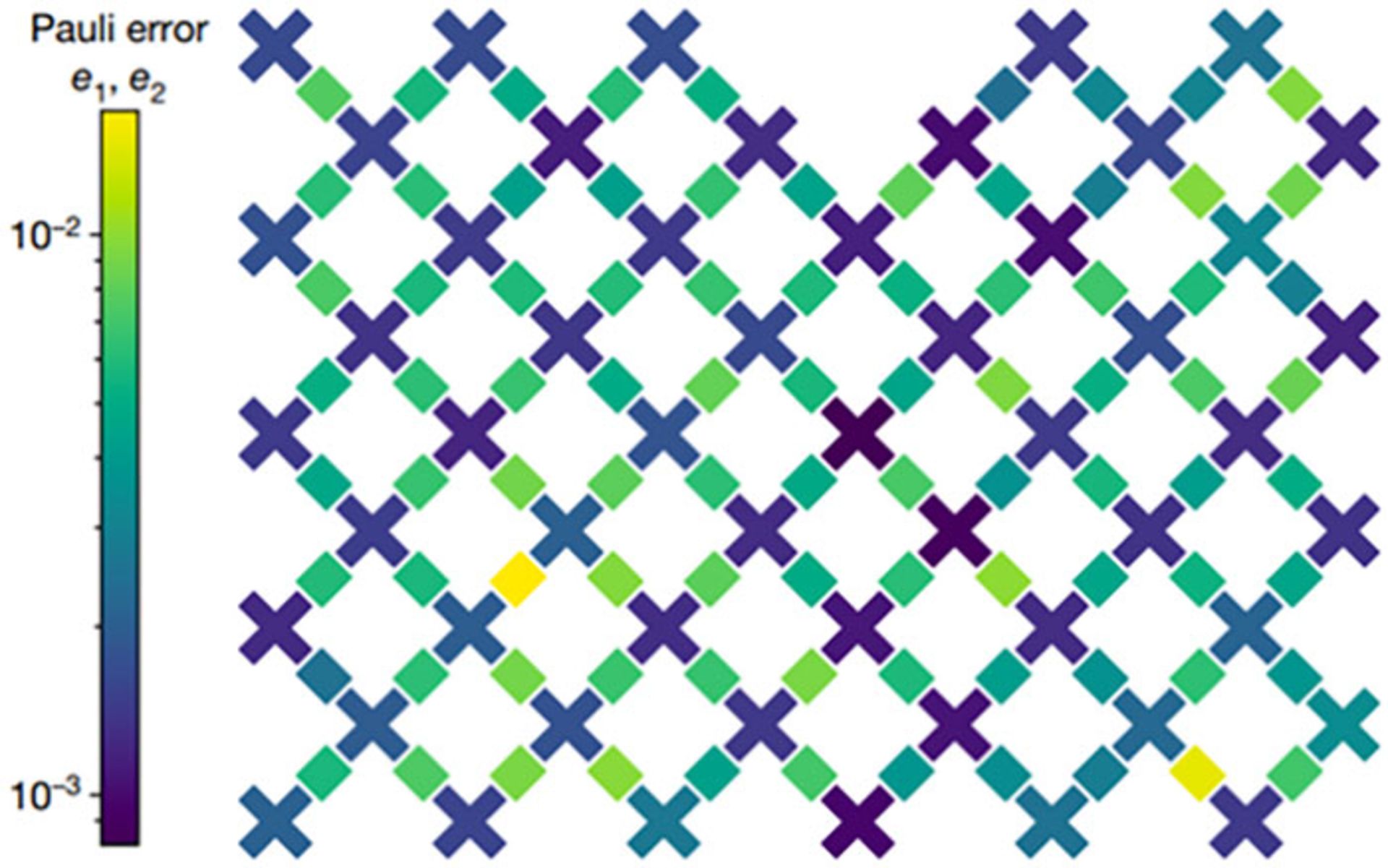

الگوی چسبندگی پردازندهی ۵۳ کیوبیتی سیکامور

کیوبیت همتای واحدهای باینری دیجیتالی در رایانش کوانتومی محسوب میشود. در تعریف کلی میتوان کیوبیت را الکترونی دانست که همراهبا تمامی ذرههای درهمتنیده، در یک میدان مغناطیسی غوطهور است. مجموعهای از کیوبیتها مانند الگوی گوگل در تصویر بالا میتوانند حجمی از داده بهاندازهی مگابایت یا گیگابایت را مانند سیستمعای باینری کلاسیک به نمایش بگذارند. چنین رویکردی به الگوریتمهای کوانتومی امکان میدهد تابعی واحد را در زمان بسیار کوتاه روی آرایهای بزرگ از داده پیادهسازی کنند.

جیمز کلارک، مدیر سختافزارهای کوانتومی اینتل لبز، دربارهی سیستمهای رایانش کوانتومی میگوید:

سیستمهای کوانتومی را مانند سکهها در نظر بگیرید. یک کیوبیت احتمال قرار گرفتن در حالت شیر یا خط را دارد. درواقع نمیتوان آن را تنها شیر یا تنها خط دانست و در تعریف دقیق، سکه هم حالت شیر و هم خط دارد.اگر دو کیوبیت داشته باشیم، حالتهای محتمل چهار عدد میشوند، بههمین ترتیب با داشتن سه کیوبیت، هشت حالت محتمل وجود دارد. درنتیجه حالتها با ترتیبی نمایی افزایش مییابند. درنهایت اگر ۵۰ سکه (نماد کیوبیت برای درک بهتر) داشته باشیم، حالتهای محتمل بیشتر از توانایی قویترین ابرکامپیوتر روی زمین برای نمایش میشوند. اگر تعداد سکهها به ۳۰۰ عدد برسد، تعداد حالتهای محتمل از تعداد اتمهای موجود روی کرهی زمین بیشتر خواهد بود. این محاسبه، نشاندهندهی مقیاس نمایی کامپیوترهای کوانتومی است و برتری آنها را نسبت به کامپیوترهای کلاسیک نشان میدهد.

جیمز کلارک

کلارک برای شبیهسازی ظرفیت کیوبیتها از محیط ابرکامپیوترهای کلاسیک استفاده کرد و از لحاظ تئوری به محدودیت ۴۵ رسید. یک لپتاپ سریع و قدرتمند حداکثر میتواند تا ۳۵ وضعیت را شبیهسازی کند. کلارک دربارهی شبیهسازی کیوبیت با کامپیوتر کلاسیک میگوید برای اضافه کردن هر کیوبیت به شبیهسازی، پیشنیازهای سختافزاری کامپیوتر کلاسیک دوبرابر میشوند. درنهایت محقق اینتل اعتقاد دارد بدون داشتند یک کامپیوتر کوانتومی بزرگ، توانایی ما در شبیهسازی الگوریتمها بسیار محدود خواهد بود.

دانشمندان و مهندسان برای تجسم مقیاس عظیم فضای مسئلهای که سیستمی با ۵۳ یا ۵۴ کیوبیت حل میکند، از ابزاری ریاضیاتی بهنام فضای هیلبرت استفاده میکنند. این فضا یک شبکهی هندسی تمثیلی است که هر نقطه از آن امکان اتخاذ یک مقدار را دارد. در سیستمهای الکترونیکی کلاسیک، مقدار هر نقطه با وجود یا غیاب الکترون در بیتها تعریف میشود. هر هشت بیت نمایانگر یک بایت میشوند که توانایی نمایش هر عدد صحیح بین صفر تا ۲۵۵ (یا ۱۲۷- تا ۱۲۷) را دارد. با چنین تعریفی میدانیم که هر بایت هشت بیتی، فضای هیلبرت محدودی دارد. این فضا را بهصورت شکافی در نظر بگیرید که راهحل تابع الگوریتمی باید در آن جای بگیرد.

کیوبیت برخلاف بیت محدود به حالتهای صفر و یک نیست

در فضای هیلبرت کامپیوتر کوانتومی، هر کیوبیت بهجای حالتهای صفر و یک، میتواند نمایانگر ۲۵۳ حالت کوانتومی باشد که درمجموع بیش از ۹ میلیون میلیارد حالت میشود. همهی آنها بهجز بزرگترین و کوچکترین نیز بهعنوان فازهای سوپرپوزیشن شناخته میشوند. در قیاس مشهور اروین شرودینگر، از بنیانگذاران فیزیک کوانتوم، تمامی این حالتهای میانی سورپوزیشن، وضعیتهایی هستند که گربهی شرودینگر بهصورت همزمان زنده و مرده خواهد بود. مجموعهای از ۵۳ کیوبیت درهمتنیده، فضای هیلبرتی دارد که تنها توسط یک کامپیوتر باینری هشت بیتی با یک پتابایت حافظه (برابر با ۱۰۲۴ ترابایت) قابل شبیهسازی خواهد بود. بهبیان دیگر، یک پتابایت بهمعنای فضای راهحلی پردازنده شناخته میشود.

باتوجه به توضیحات بالا به این نکته توجه کنید که یک پتابایت حافظهی واقعی در کاربرد با یک دیتابیس، میتواند نمایانگر حجم بالایی از داده باشد. در سیستمهای کلاسیک کنونی، سریعترین ابزارهای مدیریت دیتابیس از موتورهای داخل حافظه استفاده میکنند. اگر کیوبیتها را به شکل حافظه در نظر بگیریم، میتوان یک عملیات کوانتومی را در مجموعهای از کیوبیتها با سرعتی برابر با انجام یک عملیات منطقی باینری ساده با یک چرخهی کلاک نیمههادی در دیتابیسی با حافظهی یک پتابایتی انجام داد.

عدم انسجام

پروفسور جان پرسکیل، از مؤسسهی فناوری کالیفرنیا، در سال ۲۰۱۱ مقالهای به مناسبت بیستوپنجمین سالگرد کنفرانس فیزیک سولوی منتشر کرد. او مفهومی قابل درک و تاریخی را با عبارت «برتری کوانتومی» به دنیای رایانش کوانتومی افزود. پرسکیل دربارهی سریعترین راه احتمالی برای رسیدن به این برتری میگوید:

یکی از راههای رسیدن به برتری کوانتومی، اجرای الگوریتمی در یک کامپیوتر کوانتومی است که مسئلهای را با سرعتی فراچندجملهای نسبت به کامپیوترهای کلاسیک حل کند.

منظور پرسکیل از عبارت «سرعت فراچندجملهای» در مقالهی مذکور، درجهای از سرعت بود که نتوان آن را با فرمولهای چندجملهای تعریف کرد. درواقع منظور او تفاوتی است که قابل توضیح و شرح با مفاهیم ریاضیاتی مرسوم نباشد.

جان پرسکیل

برای درک بهتر اظهارنظر پرسکیل، این موارد را در نظر بگیرید: هر تابع تحلیلی ریاضی که در یک سطح به کار برده میشود، با افزایش ابعاد سطح تحلیلی بهصورت خطی، باید بهصورت نمایی پیچیدهتر شود. درنتیجه، تابع زمان بیشتری را برای اجرا به خود اختصاص میدهد تا اینکه به نقطهی تنگنا برسد. پدیدهی مذکور، برای کیوبیتهای درهمتنیده (نمایانگر حافظه و نودهای داده در سیستمهای کوانتومی) رخ نمیدهد. یک تابع زمانیکه در سطوح بزرگتر به کار برده میشود، نسبت به سطوح کوچکتر زمان تقریبا کم یا حتی غیرقابل اندازهگیری نیاز دارد. یک مرز تقریبی وجود دارد که رایانش کلاسیک توانایی عبور از آن را ندارد و زمان صرفشده برای حل مسئله در آن، به بینهایت میل میکند. سیستمهای کوانتومی در همین مرز، بهصورتی حرکت میکنند که گویی هیچ تغییر خاصی رخ نداده است.

مرزی که در بالا شرح دادیم، طبق تعریف پرسکیل همان نقطهی برتری کوانتومی خواهد بود. تیم گوگل ادعا میکند که با سیکامور، به نقطهی برتری رسیده است. اکنون این سؤال ایجاد میشود که آیا روشی قابل اعتماد برای بررسی ادعای آنها یا هر ادعای برتری کوانتومی دیگر وجود دارد؟ روشی که نیازمند بیش از ۱۰ هزار سال محاسبهی بدون وقفه نباشد؟

دکتر تراویس هامبل، دانشمند برجستهی آزمایشگاه ملی اوک ریج، دربارهی برتری کوانتومی میگوید:

یک تمایل عمومی در جامعهی رایانش کوانتومی وجود دارد تا ابزاری برای اندازهگیری حرکت ما به سمت کامپیوترهای کوانتومی به دست آورده شود. تعریف پرسکیل از برتری کوانتومی، تعریف ایدهآل مناسبی از لحاظ آکادمیک ارائه کرده؛ اما متأسفانه چگونگی پیادهسازی ایده را ارائه نکرد.

شایان ذکر است اولین و دومین ابرکامپیوترهای قدرتمند جهان یعنی سامیت و سیرا در آزمایشگاه اوک ریج قرار دارند که از پیشرفتهترین آزمایشگاههای اختصاصی رایانش حرفهای محسوب میشود.

تراویس هامبل

سیکامور توانایی تشکیل یک دستگاه کوانتومی با ۵۴ کیوبیت درهمتنیده را دارد و گوگل در آزمایشگاه خود به مرز ۵۳ کیوبیت رسید. درهمتنیده کردن رشتههای طولانی کیوبیت، دشواری زیادی دارد؛ چرا که قطعات مونتاژ شده مستعد جدا شدن و تجذیه هستند. مهندسان گوگل در مقالهی Nature، آزمایش انجامشده با سیکامور را شرح دادند. در آزمایش مذکور، سیکامور احتمال توزیعها را درمجموعهای از مقادیر در دستهای بزرگ از الگوهای دادههای باینری تخمین زد. رویکردی که شبیه به پیدا کردن کدهای کاراکتر اسکی (ASCII) در میان کلمههای مخفی در یک تصویر سیاه روی یک دیوار سفید تشریح میشود.

برتری کوانتومی یک معیار ثابت نیست و بهنوعی همیشه در حال تغییر است

مقالهی گوگل ادعا میکند که در یک نقطهی مشخص، سیکامور توانست احتمالهای توزیع را در ۲۰۰ ثانیه محاسبه کند. رخدادی که برای یک ابرکامپیوتر کلاسیک، ۱۰ هزار سال به طول خواهد انجامید. گوگل ادعای ۱۰ هزار سال زمان را براساس شبیهسازی مبتنی بر کامپیوتر باینری مطرح کرد. در این شبیهسازی، مجموعهای از مسائل کوچکتر بررسی شدند و سپس فرمول نمایی برای مقیاسدهی به مسائل تا رسیدن به ابعاد مسئلهی سیکامور، در اختیار مهندسان قرار گرفت.

دکتر سرگی فرولوف، فیزیکدان تجربی داتشگاه پیتزبرگ و مدیر آزمایشگاه فرولوف است. او در آزمایشگاه خود رفتار و داینامیک مواد را در مقیاس نانو مورد بررسی قرار میدهد. فرولوف دربارهی اصلاح برتری کوانتومی پرسکیل میگوید این معیار یک محاسبهی آماری دائمی نیست و مثلا نمیتوان آن را با رکوردی علمی همچون ارسال اولین انسان به ماه مقایسه کرد. درواقع، برتری کوانتومی یک معیار عملیاتی خواهد بود که همیشه جریان دارد:

از لحاظ ریاضیاتی نمیتوان اثباتی اینچنین داشت. درواقع نمیتوانید بگویید که مثلا با داشتن ۵۰ کیوبیت در یک کامپیوتر کوانتومی، دیگر هیچ کامپیوتر کلاسیکی توانایی رقابت با آن را نحواهد داشت. مفهوم مذکور یک فرایند عملیاتی است. بهبیان دیگر در نقطهای از زمان، کامپیوتر کوانتومی عملکردی سریعتر از هر کامپیوتر کلاسیک دارد. مهندسان کوانتوم امیدوار هستند که احتمال رسیدن برتری بهدست آمده، بهصورت نمایی افزایش یابد تا دیگر احتمالی برای رقابت با آن وجود نداشته باشد. چنین برتری شاید در آیندهی نزدیک رخ دهد؛ درنتیجه اگر گوگل بهجای ۵۳ کیوبیت، ۶۰ یا ۷۰ کیوبیت داشت، احتمال رقابت و برابری کامپیوترهای کلاسیک در آن وظیفهی خاص با کامپیوتر کوانتومی، تقریبا بهصورت کامل از بین میرفت.

سرگی فرولوف

IBM دربرابر ادعای گوگل واکنش نشان داد و بهنوعی تعریف رقیب را از محاسبه به کامپیوتر کلاسیک، به چالش کشید. صورت معادلهی برتری کوانتومی، قدرت کامپیوتر کوانتومی و مخرج آن، نشاندهندهی قابلیتهای کامپیوتر کلاسیک است. IBM مخرج معادلهی گوگل را به چالش میکشد. پرسکیل در تعریف برتری کوانتومی کامپیوتر کلاسیک را ملزم به شبیهسازی یا تقلید یا تظاهر به تشکیل چرخهی کوانتومی نکرد. ریچارد فاینمن، بنیانگذار ایدهی رایانش کوانتومی، در مقالهای هرگونه شبیهسازی یا رویکرد مذکور را غیرممکن عنوان کرده بود.

مهندسان IBM رویکردی دیگر در مسیر رایانش کوانتومی دارند. آنها در حال کار روی رویکردی برای تقسیمبندی حافظههای حالت جامد (مدارهای فلش) هستند که البته هنوز آزمایش نشده است. آنها با استفاده از الگوهایی شبیه به مثالهای بالا، هر بخش را در کیوبیتهای شبیهسازی شدهی متعدد بهکار میگیرند. با استفاده از روش احتمالی IBM، کامپیوتر کوانتومی در نوشتن و خواندن دادهها به مشک برخورد نمیکند. مشکل و تنگنایی که از نظر مهندسان IBM در پیشبینی اولیهی ۱۰ هزار سال زمان از سوی گوگل، بیتأثیر نبود.

هامبل در توضیح رویکرد گوگل میگوید: «تیم گوگل در رویکرد خود قصد نشان دادن این حقیقت را داشت که رفتار دستگاه کوانتومی، توسط هیچ کامپیوتر کلاسیکی قابل انجام نخواهد بود». درواقع او اعتقاد دارد گوگل به دانشمندان و مهندسان این حوزه نشان داد که باید معنای برتری کوانتومی را بازتعریف کنند. هامبل موقعیت جالبی در درگیریهای کوانتومی دارد. او هم با گوگل و هم با IBM پروژههای مشترکی انجام میدهد و در مصاحبهای دربارهی آنها گفت:

اسناد ما نشان میدهند که بهترین روش کلاسیک برای مقایسهی کامپیوترها، در نرمافزار شبیهسازی تیم ناسا ارائه میشود. بهعلاوه، اعتبارسنجی انجامشده با استفاده از روش شبیهسازی مذکور، یک دستاورد قابلتوجه بود. IBM روشی جایگزین را پیشنهاد داد که احتمالا در اعتبارسنجی سریعتر، کاربردی و قابل پیادهسازی خواهد بود. بههرحال در دنیای علمی رویکردی داریم که گروههای تحقیقاتی، با تکیه بر دستاوردهای یکدیگر، موفقیتهایی را کسب میکنند. بههمین دلیل من اعتقاد دارد جوابیهی IBM نفی دستاوردهای گوگل نبود. درواقع آنها بینشی بیشتر ارائه کردند تا در آینده ایدههای اینچنینی را دقیقتر بررسی و اعتبار سنجی کنیم.

برای درک بهتر ادعاهای برتری شرکتها در رایانش کوانتومی، میتوان مثالهایی از دنیای رایانش کلاسیک را بررسی کرد. اینتل و AMD سالها پیش درگیری شدیدی در اثبات برتری کارایی پردازندههای دوهستهای داشتند که شباهت جالبی به درگیری کنونی در دنیای کوانتوم داشت. وقتی یک تولیدکننده، ادعای برتری در کلاس خاصی از کارایی را نسبت به تولیدکنندهی دیگر داشته باشد، جوابیههایی از طرف رقیب اعلام میشود تا محدودیتهای تئوری و عملی ادعا را ثابت کند. بهعنوان مثالی از ادعاهای کلاسیک میتوانید برتری در تستهای بنچمارک کدکهای ویدئویی یا عبور از مرزهایی فرضی در قدرت پردازش را در نظر بگیرید.

توضیح ادعا

شرکتی که ادعای برتری را ابتدا مطرح میکند، برای توضیح هرچه بیشتر جزئیات ادعا و تلاش برای مقابله با کارشناسان جزئینگر، اصطلاحات متعددی را در پایان ارائهی خود شرح میدهد. درواقع این توضیحات را میتوان شبیه پاورقی دانست که بهنوعی عملکرد سلب مسئولیت را هم دارند. اگر قرار بود گوگل برای ادعای برتری کوانتومی خود پاورقی ارائه کند، عبارتهای زیر کاربرد مناسبی داشتند:

مخرج معادلهی برتری امکان تغییر بدون اطلاع را دارد

نرخ کارایی یک سیستم کوانتومی برتر نسبت به هر کامپیوتر کلاسیک، طبق تعریف پرسکیل یک عدد خیالی است (یک تقسیم بر بینهایت). تا زمانیکه برای تعاریف و محاسبهها از مفاهیمی همچون بینهایت یا معیارهای خیالی استفاده کنیم، هر ادعای چالشی از سمت دنیای کلاسیک، حتی پیش از بررسیهای آزمایشی، مخرج تابع محاسباتی را از حالت خیالی خارج میکند و به دنیای واقعی میآورد. درنهایت نرخ مذکور به مقداری واقعی تبدیل میشود. در تعریف ساده تا زمانیکه نرخ کارایی بهصورت فرضی مطرح شود، نمیتوان برتری کوانتومی را تضمین کرد.

اگر رایانش کوانتومی بخواهد تأثیری در اقتصاد جهانی داشته باشد، باید برتری کوانتومی، ارزش افزودهاش را در دورهی زمانی حداقل برابر با زمان کمپین تبلیغاتی حفظ کند. اگر یک ابرکامپیوتر کلاسیک رقیب بتواند ادعای برتری را در چند هفته به یک برتری ساده تقلیل دهد، توجیه قیمت بیشتر برای کامپیوتر کوانتومی و قابلیتهایش، با سرعتی بسیار بیشتر از توانایی ۵۴ کیوبیتی سیکامور، از بین میرود.

فرولوف درادامهی صحبتهایش دربارهی برتری کوانتومی میگوید:

هیچ قصیهای ادعای عدم توانایی الگوریتمهای کلاسیک در شکست دادن الگوریتمهای کوانتومی را مطرح نمیکند. ما تنها میتوانیم ادعا کنیم که در این نقطهی زمانی، این کامپیوتر کوانتومی خاص، توانایی شکست این کامپیوترهای کلاسیک کنونی را داشته است. ازطرفی، بههیچوجه نمیتوان اثبات کرد هر کامپیوتر کلاسیک در هر دورهی زمانی، توانایی شکست دادن یا همتراز شدن با یک کامپیوتر کوانتومی را ندارد.

IBM میگوید برای بررسی برتری کوانتومی به معیارهای دقیقتری نیاز داریم

باتوجه به توضیح فرولوف میتوان نتیجه گرفت که هر ادعای برتری کوانتومی تنها در مقایسه با دادن شانس مساوی به کامپیوتر کلاسیک قابل بررسی خواهد بود؛ کامپیوتر کلاسیکی که در حل همان مسئلهی برابر، با روشهای خود شکست بخورد. ادعای گوگل را میتوان اولین نمونه در تاریخ دانست که با همین درجه از اعتبار مطرح شد. ازطرفی ابعاد چالشی که IBM برای ادعای مذکور مطرح کرد، نشاندهندهی آمادگی همهی رقبا در حوزههای وسیعتر رایانش یا ابررایانش برای انجام عملکردهای مشابه در آینده است.

شایان ذکر است ZDNet برای اظهارنظر دربارهی ادعاهای مقالهی حاضر، با گوگل و IBM تماس برقرار کرد که هیچکدام پاسخی ارائه ندادند.

اثرات جانبی احتمالا در برخی موارد باعث عدم قطعیت یا عدم انسجام یا عدم توانایی میشوند

فرولوف دربارهی رایانش کوانتومی ایدهآل میگوید:

در یک کامپیوتر کوانتومی ایدهآل میتوان هر ذرهای را با ذرهی دیگر درهمتنیده کرد و هیچ مشکلی هم ایجاد نمیشود. چنین رویکردی احتمالا تا سالهای آتی ممکن نخواهد بود. در یک کامپیوتر کوانتومی کاربردی، درهمتنیدگی در ابعاد کوچک وجود دارد و بهنوعی تا طولانیمدت حفظ نمیشود. منظور از زمان کوتاه، سال و روز نیست، بلکه در مقیاس ثانیه و حتی میلیثانیه صحبت میکنیم.

باتوجه به روشی که فرولوف برای تصویرسازی مسئله استفاده میکند، موفقیت سیکامور را میتوان یک رخداد موفق در میان چندین بار آزمایش و بررسی بیان کرد. پیچیدگی آزمایشها نیز با اضافه کردن هر کیوبیت، چندین برابر میشود. بههمین دلیل گوگل نتوانست کیوبیت ۵۴ را به کامپیوتر خود اضافه کند.

مطالعهی پاورقی، یعنی شما قوانین فیزیکی را پذیرفتهاید که هیچکس آنها را درک نمیکند

آزمایش پردازندهی سیکامور عمدا دشوار طراحی شده بود. مسئلهی مذکور، مثالی از فرایند نمونهسازی جریان تصادفی (RCS) بود که بهنام نمونهسازی بوزون (Boson Sampling) شناخته میشود. فوتون (ذرهی کوانتومی حاوی نور که تمامی مکانیک کوانتوم از آن مشتق میشود)، مشهورترین بوزون است. البته نمونههای عجیبوغریب دیگری هم وجود دارند.

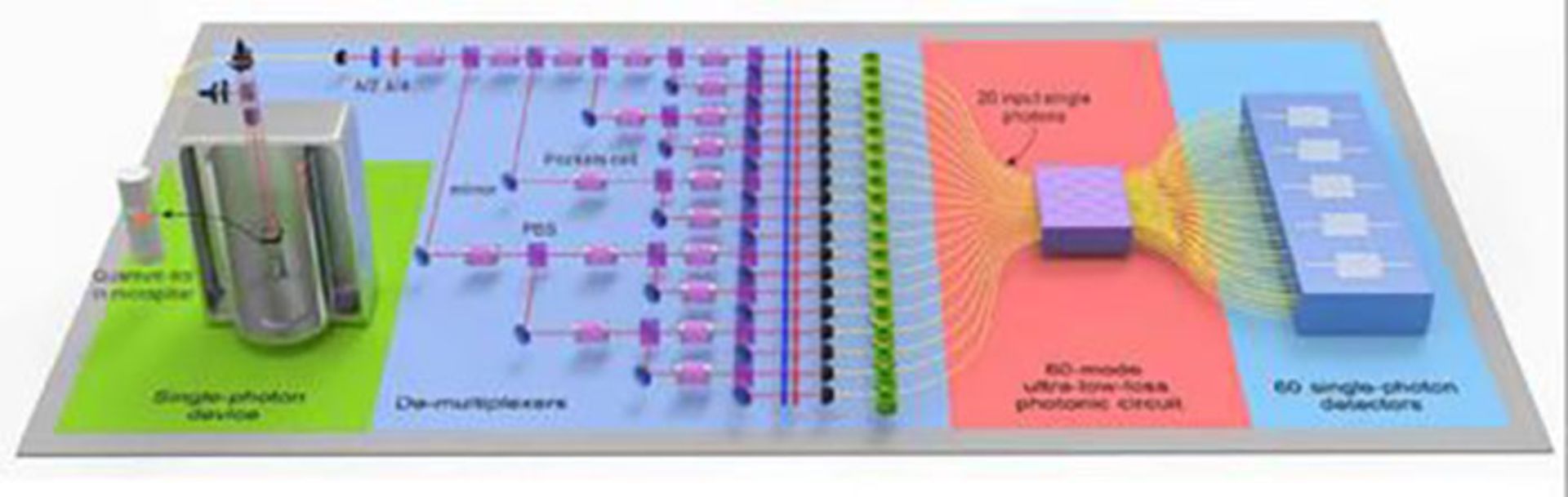

دستگاه نمونهسازی بوزون

تصویر بالا، یک دستگاه واقعی نمونهساز بوزون محسوب میشود. هدف چنین دستگاههایی پیادهسازی آزمایشی است که در آن، بوزونهای بسیار (اکثرا فوتون) از یک منبع واحد بهنام کوانتوم دات (کریستالی مصنوعی که در معرض اشعههای فرابنفش، از خود نور ساطع میکند) شلیک میشوند. بوزونها از مسیری شبیه به هزارتو موسوم به تداخلسنج تصادفی Haar عبور میکنند و با رسیدن به بخش روبهرو، آشکارسازهایی برای گرفتار کردن آنها وجود دارند. الگوریتمهای RCS با استفاده از ورودیهای مناسب توانایی تخمین دقیق توالی گرفتن بوزونها را در هر آرایهی ارسالی (در نمونهای تصادفی از رخدادها) دارند.

برای تعریف واقعی پیچیدگی ساختار بالا میتوان چنین تعریفی را مطرح کرد: ۱۵ گیرندهی توپ را در یک زمین بیسبال قرار دهید و از آنها بخواهید که ساکت باشند. زمین را تاریک و دید پرتابکنندهی توپ را نیز مسدود کنید. تنها منبع نور، باید توپهای بیسبال باشند که خود را روشن میکنند. سپس پرتابکننده را چند بار دور خود بچرخانید و صدها توپ را به فاصلهی دور پرتاب کنید. با استفاده از مجموعهای از پرههای موتور جت، مسیر توپها را در میانهی حرکت تغییر دهید. به دریافتکنندهها بگویید که تا حد امکان، توپها را دریافت کنند و در نظر داشته باشند که احتمالا یک یا دو توپ را از دست خواهند داد. این فرضیه را بهصورت مسئلهای کامپیوتری در نظر بگیرید. اکنون با ارائهی ضربان قلب و نرخ تنفس پرتابکننده، سرعت چرخش و نرخ مصرف برق در پرههای فن موتور جت و وزن و ابعاد کفش هریک از دریافتکنندهها، زمان و مکان حداکثر دریافتهای موفق را از پرتابی پس از پرتاب اول (مثلا هفدهم) محاسبه کنید.

مجلهی Scientific American در ششم نوامبر گزارشی از انتشار یک مقاله داد که هنوز داوری همتا را نگذارنده بود. مقالهی مذکور، رکورد جدیدی را در دنیای پردازش مطرح میکرد. یک روش نمونهسازی بوزون با استفاده از اشعهی تداخلسنج واقعی در مقاله شرح داده شده بود که پیشبینی دقیق یک توالی شامل ۱۴ مجموعهی بوزون تصادفی را داشت. نتیجهگیری مقاله بررسی نشده بود؛ اما بههرحال نام گروهی از محققان دانشگاه علوم و فناوری هفی در چین، در آن دیده میشد.

طرح اجزاء تشکیلدهنده نمونهساز بوزون

نتایج گروه تحقیقاتی چین در حفظ وضعیت آزمایش نمونهسازی بوزون برای ۱۴ مرتبهی متوالی، یک دستاورد قابلتوجه محسوب میشود. همین نتایج نشان میدهند که نهتنها برای توسعه، بلکه برای اجرای الگوریتمی شبیه به رفتار کامپیوترهای کوانتومی، تلاشهای بیشماری نیاز خواهد بود. بههرحال امروز تاحدودی میدانیم که کامپیوترهای کوانتومی برای کاربردهای عادی استفاده نمیشوند و شاید هیچگاه هم استفاده نشوند. بههمین دلیل برتری آنها نیز تنها در حوزههای محدود قابل بررسی خواهد بود و همین مورد، چالشی بزرگ در دنیای پردازش است.

برتری کوانتومی احتمالا در همهی زمینهها قابل دسترسی نخواهد بود

تفکر مرسوم باعث این تصور از سوی مردم میشود که در صورت موفقیت کامپیوتر کوانتومی در اجرای الگوریتمی به پیچیدگی نمونهساز بوزون، میتوان از آن در کاربردهای واقعی استفاده کرد. مدیرعامل گوگل، ساندار پیچای، در وبلاگ سازمانی خود نوشت:

رایانش کوانتومی میتواند به توسعهی راهکار برای مسائلی همچون تغییرهای اقلیمی تا درمان بیماری شتاب دهد. ما با این دستاورد، یک قدم به پیادهسازی رایانش کوانتومی در مواردی همچون طراحی باتریهای بهتر، تولید کود با انرژی کمتر و درک کاربردهای درمانی مولکولهای گوناگون، نزدیک شدهایم.

عدم پایداری کامپیوترهای کوانتومی، چالش بزرگ محاسبه بهکمک آنها است

مشکل اصلی تعریف پیچای و پیچیدگی رایانش کوانتومی در فرضیههای ابتدایی آزمایش دیده میشود. نمونهسازی بوزون نهتنها بهخاطر دشواریاش انتخاب شد؛ بلکه دستهبندی مسئلهی آن نیز بهگونهای است که تنها توسط کامپیوترهای کوانتومی قابل اجرا خواهد بود. در توضیح دشواری مسائل کوانتومی و کامپیوترها، مثال زیر را در نظر بگیرید:

شما با بهترین ریاضیدان زندهی دنیا ارتباط دارید؛ اما ارتباط شما محدود به حبس بودن او در سلولی انفرادی در زندان آلکاتراز میشود. این شخص برای شما معجزههایی را در محاسبات ریاضی پدیدار میکند؛ اما مسئلهی شما باید او را قانع کند که یک فضانورد حاضر در فضا است. حتی با چنین فرضیههای دور از ذهنی هم ریاضیدان مذکور پس از مدتی از کار کردن با شما خسته میشود و احتمالا بهصورت ناگهانی به خواب میرود.

دانشمندان تأیید میکنند که برای ادعای برتری کوانتومی باید الگوریتمی استفاده شود که برای روشهای رایانش کلاسیک، دشوار و غیرقابل اجرا باشد. به بیان دیگر نباید بتوانید آن الگوریتم را طبق منطق سنتی ترجمه کنید. شاید چنین روشی وجود خارجی داشته باشد؛ اما هنوز هیچ کس از چگونگی دستیابی به آن آگاه نیست. همین مشخصه (یعنی ساخت تابع کوانتومی که از طریق منطق مرسوم قابل دستیابی نباشد)، برتری کوانتومی را برای تفسیر بهکمک نمادها و زبانهای مرسوم دشوار میکند. درنهایت میتوان طبق تعریف ادعا کرد برنامهنویسی یک الگوریتم مناسب کامپیوتر کوانتومی، واقعا دشوار خواهد بود.

تراویس هامبل در توضیح بیشتر دربارهی دستاوردهای اخیر میگوید:

نمایش اخیر حداقل نشان داد که ما میتوانیم کامپیوترهای کوانتومی با بیش از ۵۰ کیوبیت بسازیم و رفتار آنها را پیشبینی کنیم. درواقع بالاترین دستاورد آزمایش اخیر برای من، این موارد بود: درک ما از فرایندهای مکانیک کوانتوم، جگونگی ساختن ابرارتباطها و انتقال کیوبیتهایی که استفاده میکنند. اکنون من از دیدگاه مهندسی، دستاوردهای موجود را قابلتوجه میدانم که امید به ساختن کامپیوترهای کوانتومی واقعا کاربردی را در آینده، زنده نگه میدارد.

فرولوف در پایان صحبتهایش میگوید:

نگاشت از مسائل کلاسیک به الگوریتمهای کوانتومی را میتوان برای همهی موارد کاربردی استفاده کرد. تنها مسیری که از نظر من کاربردی نخواهد بود، مسیری است که اکنون گوگل استفاده کرده است. آنها میخواهند یک سیستم کوانتومی را در یک کامپیوتر کوانتومی مدلسازی کنند. چنین رویکردی کاملا کوانتومی محسوب میشود و ما پاسخ آن را نمیدانیم. درواقع نمیتوانیم آن را با هیچ ابزاری بررسی کنیم. بهعلاوه نمیتوان چگونگی عملکرد را هم مشاهده کرد. تنها باید به کار کردن ماشین اعتماد کنیم. اینجا با مسائل کوانتومی با پاسخهای کوانتومی روبهرو هستیم که تنها برای دانشمندان و فیزیکدانان جذاب هستند و هیچ کاربرد واقعی ندارند.شاید بتوان از دستاوردهای آزمایش کوانتومی، برای کشف پدیدهای جذاب، مانند ابررسانایی در دمای اتاق، استفاده کرد. با استفاده از آن میتوان الکتریسیته را بدون هدررفت به سرتاسر جهان ارسال کرد که قطعا کاربرد بالایی برای جامعه دارد. تنها با چنین کاربردهایی میتوان پاسخ کامپیوتر کوانتومی را بررسی کرد (تصور کنید ما از کامپیوتر مشخصات یک ماده را خواستیم و آن، مادهی ابررسانا را معرفی کرد). در این فرضیه میتوان ماده را تولید کرد و بازدهی و موفقیت آن را مورد آزمایش قرار داد. کاربردهای دیگری مانند بهینهسازی مسائل امنیت سایبری هم وجود دارند که میتوان با سرعت بالا، آنها را بررسی کرد.

الگوریتمهای کوانتومی مخصوص پردازندههای کوانتومی هستند و احتمالا برای کاربردهای دیگر استفادهای ندارند

تلاش برای توسعهی رایانش کوانتومی، ابرکامپیوترها را نیز پیشرفت میدهد

بررسی عمیقتر الگوریتمهای کوانتومی شبیه به آزمایش فکری اینشتین بهنظر میرسد. مشکل الگوریتم کوانتومی در سیستمهایی با تعداد محدود کیوبیت و عدم کاهش سرعت با افزایش ابعاد مسئله، آنجا دیده میشود که نمیتوان سرعت سیستم را افزایش داد. تنها راه بهبود سیستم، افزایش تعداد کیوبیتها است که چالشی بسیار پیچیده از لحاظ معماری محسوب میشود. درنهایت هر بار که قصد بهبود قدرت پردازشی سیستم خود را دارید، گویی یک کامپیوتر جدید توسعه میدهید. درمقابل، برای بهبود سرعت ابرکامپیوترها میتوان از نرمافزارهای متعدد استفاده کرد.

رقابت کامپیوترهای کلاسیک و کوانتومی را نمیتوان با رقابتی همچون دوومیدانی مقایسه کرد. درواقع کامپیوتر کوانتومی با سرعتی بالا به دستاوردهای متعدد میرسد و ابررایانش کلاسیک، در مسیری برای رسیدن به آن تلاش میکند. بدین ترتیب شاید بتوان رایانش کوانتومی را بزرگترین مشوق برای پیشرفت ابرکامپیوترها دانست.

هامبل دربارهی رویکردهای پردازشی و پیشرفت در دنیای رایانش میگوید:

ما همیشه بهدنبال دستیابی به جنبهای از راحتی با فناوریهای کامپیوتری بودهایم. کوانتوم هنوز توانایی ارائهی چنین سطحی از راحتی را ندارد. درواقع هنوز در فاز بسیار آزمایشی قرار داریم. ما قطعا فشارهایی را از سمت جامعه احساس خوهیم کرد تا فناوری را به وضعیت کاربردی برسانیم و طراحی را در آن مسیر پیش ببریم. مردم درنهایت برای دسترسی به چنین سیستمهایی درخواست میدهند؛ درخواستی که منجر به افزایش توسعهی سیستمها در مسیر دستیابی بیشتر خواهد شد. درنهایت به درجهای از تکامل میرسیم که دستگاههایی با قابلیت استخراج تمامی قابلیتهای منحصربهفرد کوانتوم تولید کنیم.

تحقیقات رایانش کوانتومی اکنون با سرمایهگذاریهایی پیش میرود که آیندهی آنها را نشانه رفتهاند. در سالهای پیشرو نیز سرمایهگذاری با همین رویکرد پیش میرود. سرمایهگذاری که مبتنی بر جذابیت اخبار و ادعاها نیست. درواقع، وضعیت کنونی سرمایهگذاری و فناوریهای مرتبط با رایانش کوانتومی، در یک پارادوکس قرار دارد. ارزش کاربردی پروژه در پایان توسعهی آن، سرمایهگاری مراحل آزمایشی ابتدایی را شکل میدهد. اگر فناوری نتواند روشی برای نگاشت فضای هیلبرت به دنیای واقعی پیدا کند، رایانش کوانتومی تنها فرمانروای جزیرهی دورافتادهی خود باقی خواهد ماند.

نظرات