شبکه عصبی عمیق به رمزگشایی نحوهی عملکرد مغز کمک میکند

در زمستان سال ۲۰۱۱ دانیل یامینز ،پژوهشگر علوم اعصاب محاسباتی در مؤسسه فناوری ماساچوست، گاهی اوقات تا پاسی از شب روی پروژهی بینایی ماشین خود کار میکرد. او با راهنمایی استادش جیمز دیکارلو، در حال طراحی سیستمی بود که بتواند اشیاء موجود در تصاویر را بدون توجه به تغییرات اندازه و خصوصیات دیگر تشخیص دهد. این سیستم، یک شبکهی عصبی عمیق بود که نوعی ابزار محاسباتی است و از ارتباطات عصبی موجود در مغزهای زنده الهام گرفته شده. یامینز درنهایت موفق شد و شبکهای عصبی طراحی کرد که این وظیفه را انجام میداد.

موفقیت یامینز تنها یکی از دستاوردهای قابل توجه در هوش مصنوعی بود که شبکههای عصبی را به ابزار محبوب این فناوری تبدیل میکرد؛ اما هدف اصلی یامینز و همکارانش این نبود. آنها به دنبال ایجاد مدلهای محاسباتی بودند که عملکرد مغز را نشان دهد.

دیکارلو و یامینز از اعضای انجمن دانشمندان علوم اعصاب هستند که از شبکههای یادگیری عمیق برای درک معماری مغز استفاده میکنند. این دانشمندان در تلاش برای درک علل پشتصحنهی تخصص مغز برای انجام وظایف مختلف بودهاند. آنها نهتنها در این مورد کنجکاو بودهاند که چرا قسمتهای مختلف مغز وظایف مختلفی انجام میدهد، بلکه چرا این تفاوتها میتواند بسیار ویژه باشد: برای مثال، چرا مغز منطقهای برای تشخیص کلی اشیاء دارد؛ اما بهطور خاص منطقهای نیز برای تشخیص چهره دارد.

پژوهشگران نشان دادهاند شبکههای یادگیری عمیقی که در طبقهبندی گفتار، موسیقی و بوهای شبیهسازیشده کارآمد هستند،ساختاری نظیر سیستمهای شنوایی و بویایی مغز دارند. چنین شباهتهایی همچنین در شبکههای عمیقی نشان داده میشود که میتوانند با یررسی صحنهای دوبعدی، ویژگیهای اشیاء سهبعدی درون صحنه را استنباط کنند.

شبکههای عمیق و بینایی

شبکههای عصبی مصنوعی از اتصال اجزایی به نام پرسپترون تشکیل میشوند که مدلهای دیجیتال سادهای از نورونهای زیستی هستند. این شبکهها حاوی حداقل دو لایه پرسپترون هستند؛ یکی برای لایهی ورودی و دیگری برای لایهی خروجی. یک یا چند لایهی پنهان بین لایهی ورودی و خروجی قرار دارد و در این حالت گفته میشود آن شبکه عمیق است. هرچه تعداد لایههای پنهان بیشتر باشد، شبکه عمیقتر است.

شبکههای عمیق را میتوان برای انتخاب الگوی دادهها آموزش داد؛ مانند الگوهایی که نشاندهندهی تصاویر گربه یا سگ هستند؛ بهطوریکه شبکه یاد بگیرد یک ورودی خاص (پیکسلهای تصویر) را با برچسب صحیح (سگ یا گربه) مرتبط کند. پس از آموزش، شبکهی عمیق باید بتواند ورودیهایی که قبلا ندیده است، طبقهبندی کند.

شبکههای یادگیری عمیق به دنبال تقلید از ساختار و عملکرد مغز هستند. البته دانشمندان عصبشناس در این مقایسه به محدودیتهای مهمی اشاره میکنند: برای مثال، نورونهای انفرادی ممکن است اطلاعات را جامعتر از پرسپترونها پردازش کنند و شبکههای عمیق غالبا به نوعی از ارتباط میان پرسپترونها که «پسانتشار» نام دارد، وابستهاند که در سیستمهای عصبی رخ نمیدهد. بااینحال برای دانشمندان علوم اعصاب محاسباتی، شبکههای عمیق از بهترین گزینههای دردسترس برای مدلسازی مغز بهشمار میروند.

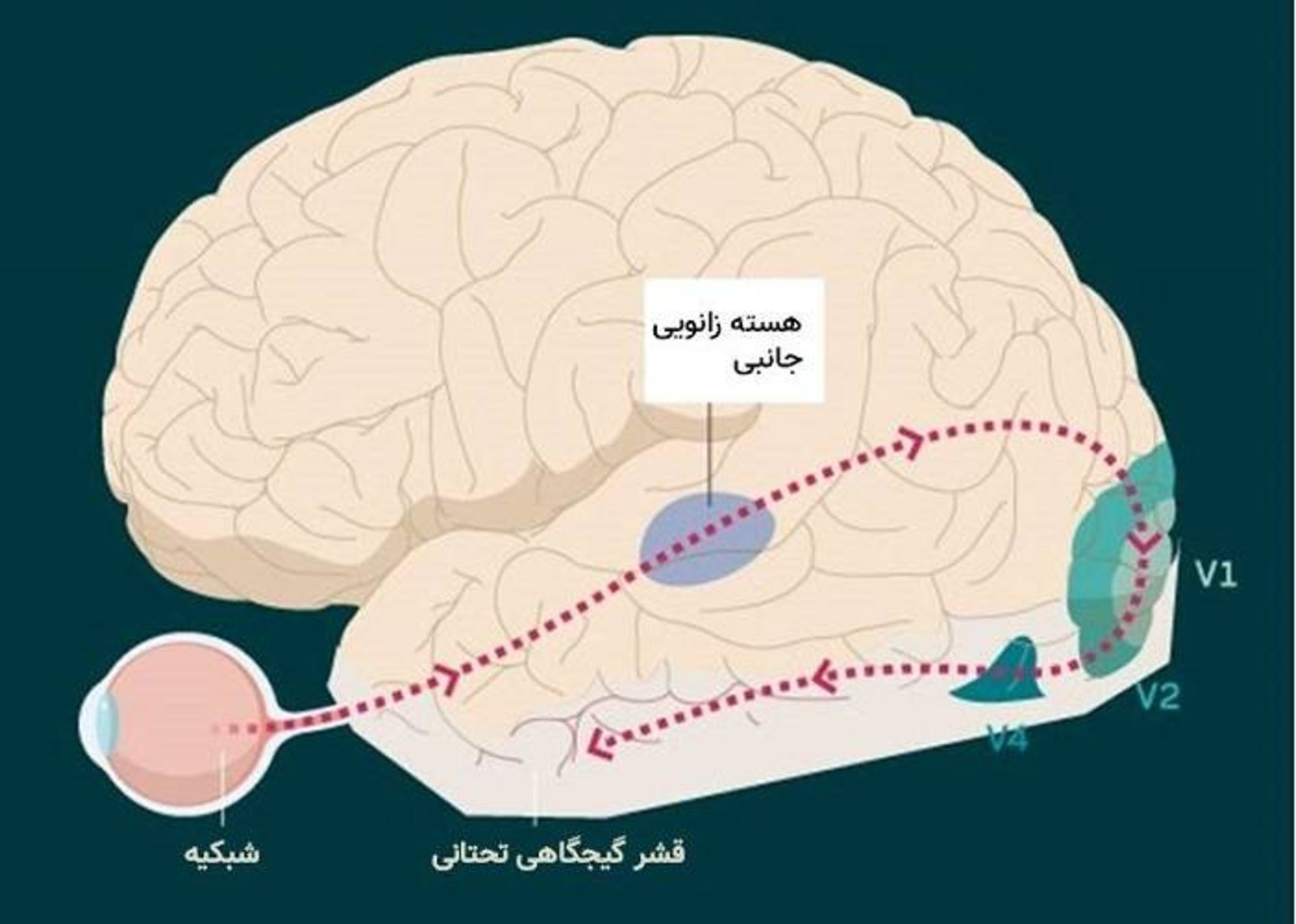

پژوهشگران توسعهدهندهی مدلهای محاسباتی سیستم بینایی، تحت تأثیر آنچه در مورد سیستم بینایی اولیه میدانیم و خصوصا مسیر مسئول تشخیص افراد، مکانها و اشیاء - که «جریان بصری شکمی» نامیده میشود - قرار گرفتهاند (مسیری جداگانهای که جریان بصری پشتی نام دارد، اطلاعات مربوط به دیدن حرکت و موقعیت اشیاء را پردازش میکند.) در انسانها، این مسیر شکمی از چشم شروع میشود و به هسته زانویی جانبی در تالاموس میرسد که نوعی ایستگاه تقویت اطلاعات حسی به شمار میرود. هسته زانویی جانبی به منطقهای بهنام V1 در قشر بینایی اولیه متصل میشود که در پاییندست آن نواحی V2 و V4 قرار گرفتهاند که در نهایت به قشر گیجگاهی تحتانی منتهی میشود.

دیدگاه اصلی علوم اعصاب این است که پردازش اطلاعات بصری بهصورت سلسله مراتبی و مرحلهای انجام میشود: مراحل اولیه، ویژگیهای ردهپایین را در میدان بینایی پردازش میکنند؛ درحالیکه نمایشهای پیچیده بعدا در قشر گیجگاهی تحتانی ظاهر میشوند.

بینشهای الهامگرفته از مغز، طراحی شبکهی عمیق یامینز و همکارانش را هدایت میکرد. شبکه یادگیری عمیق آنها دارای لایههای پنهانی بود که برخی از آنها عمل همتایی (کانولوشن) را انجام میدادند که فیلتر یکسانی بر تمام قسمتهای تصویر اعمال میکرد. هر کانولوشن خصوصیات ابتدایی مختلف تصویر را ثبت میکرد. همچون سیستم بینایی اولیه در مغز، ویژگیهای ابتداییتر در مراحل اولیهی شبکه و ویژگیهای پیچیدهتر در مراحل عمیقتر به دست میآمدند.

هنگامی که شبکه عصبی پیچشی یا شبکه عصبی کانولوشنی (CNN) برای طبقهبندی تصاویر آموزش میبیند، در ابتدا فیلترهای شبکه با مقادیر تصادفی مقداردهی میشود و سپس مقادیر صحیح مورد نیاز برای انجام وظیفه را یاد میگیرد. شبکه عصبی پیچشی چهار لایهی پژوهشگران میتوانست هشت دسته اشیاء (حیوانات، قایقها، اتومبیلها، صندلیها، چهرهها، میوهها، هواپیماها و میزها) را در ۵۷۶۰ تصویر سهبعدی واقعگرایانه تشخیص دهد.

بدون اینکه یامینز بداند، انقلابی در جهان بینایی کامپیوتر در حال وقوع بود که رویکرد او و همکارانش را بهطور مستقل تأیید میکرد. پس از اینکه آنها CNN خود را تکمیل کردند، CNN دیگری بهنام AlexNet در مسابقهی سالانهی تشخیص تصویر مشهور شد. شبکهی AlexNet نیز مبتنی بر معماری پردازش سلسله مراتبی بود که مشخصههای بصری ابتدایی را در مراحل اولیه و مشخصههای پیچیدهتر را در مراحل بالاتر میگرفت.

در مسابقهی سال ۲۰۱۲، AlexNet تمام الگوریتمهای آزمایشی دیگر را شکست داد: نرخ خطای AlexNet تنها ۱۵/۳ درصد بود؛ درحالیکه نزدیکترین رقیب آن دارای نرخ خطای ۲۶/۲ درصد بود. با پیروزی AlexNet، شبکههای عمیق به مدعیان برحق حوزهی هوش مصنوعی و یادگیری ماشین تبدیل شدند.

اما یامینز و دیگر اعضای گروه دیکارلو بهدنبال نتیجهای در زمینهی علوم اعصاب بودند. سؤال آنها این بود که اگر CNN آنها از سیستم بصری تقلید میکند، آیا میتواند پاسخهای عصبی در برابر تصویری جدید را پیشبینی کند؟ آنها برای پی بردن به این موضوع ابتدا فعالیت در مجموعهای از نورونهای مصنوعی شبکه را با فعالیت تقریبا ۳۰۰ مکان در جریان بصری شکمی دو میمون رزوس مقایسه کردند و مطابقت آنها را پیدا کردند. آنها سپس از CNN برای پیشبینی نحوهی واکنش این مکانهای مغزی هنگام نشان دادن تصویری جدید به میمونها، استفاده کردند. نتایج آنها نشاندهندهی تشابه آناتومیک بود و لایههای اولیه، میانی و آخر شبکه به ترتیب، رفتارهای مناطق اولیه، میانی و رده بالاتر مغز را پیشبینی میکرد.

شبکه عمیق ویژه برای طبقهبندی صداها

پس از ظاهر شدن نتایج یامینز و دیکارلو، جستوجوی مدلهای شبکه عمیق بهتر از مغز - خصوصا برای مناطق مغزی که نسبت به سیستم بصری اولیه کمتر مطالعه شدهاند - آغاز شد. برای مثال، جاش مکدرموت دانشمند عصبشناس مؤسسه فناوری ماساچوست، در مورد قشر شنوایی کنجکاو شد: آیا یادگیری عمیق میتواند به طرح فرضیههایی در مورد اینکه مغز چگونه صداها را پردازش میکند، کمک کند؟

گروه مکدرموت که شامل الکساندر کل و یامینز میشد، شروع به طراحی شبکههای عمیق برای طبقهبندی دو نوع صدا (موسیقی و گفتار) کردند. آنها ابتدا برای پردازش صدا و دستهبندی صداها به کانالهای فرکانس متفاوت بهعنوان ورودیهای شبکه عصبی پیچشی، به روش کدنویسی سخت مدلی از حلزون گوش ایجاد کردند. شبکهی عمیق آنها هم برای تشخیص واژهها در کلیپهای صوتی گفتار و هم برای تشخیص نوع کلیپهای موسیقی آمیخته با نویز پسزمینه آموزش داده شد. این تیم بهدنبال معماری شبکه عمیقی بود که بتواند بدون نیاز به منابع زیاد، این وظایف را بهطور دقیق انجام دهد.

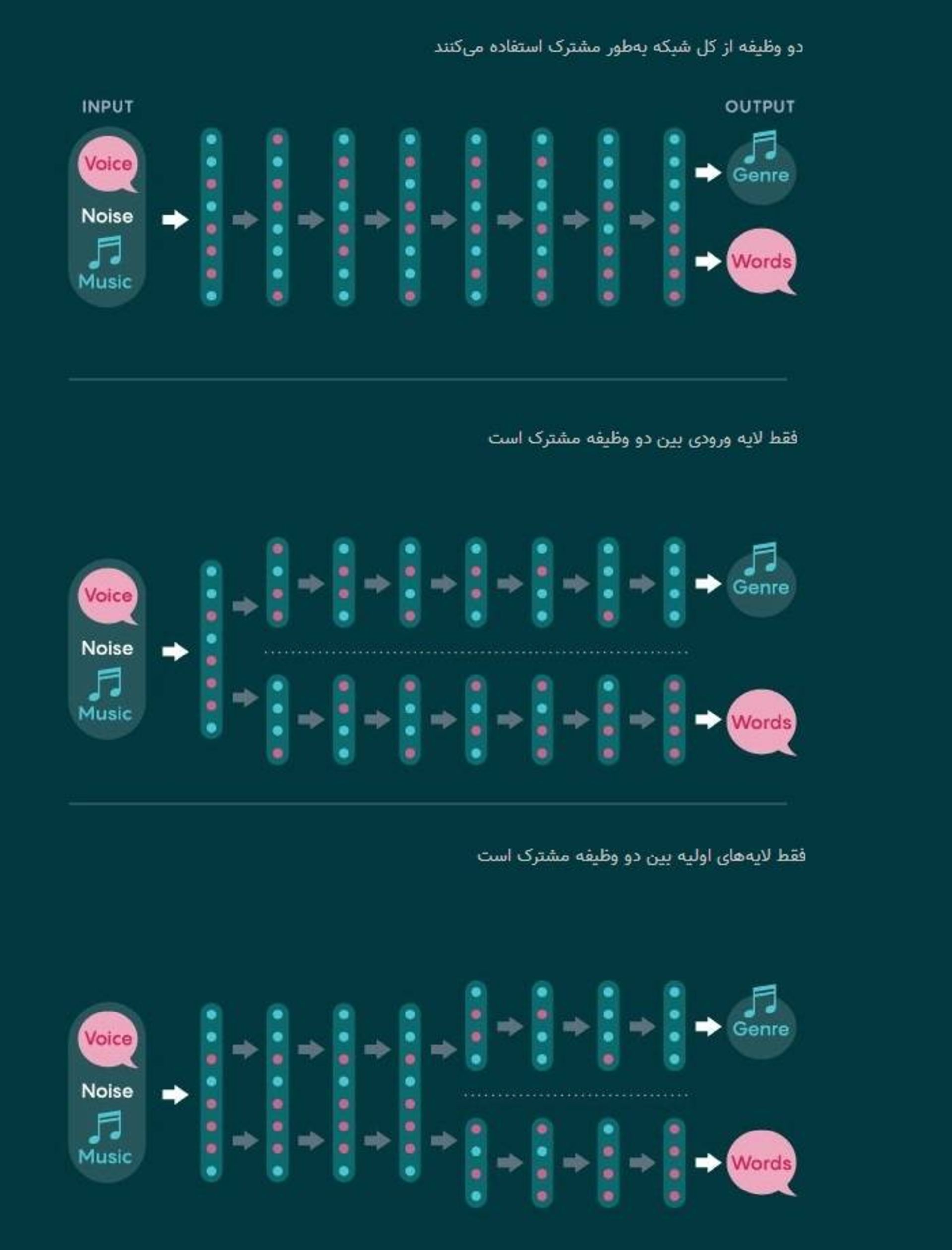

سه مجموعه معماریها ممکن به نظر میرسید. دو وظیفهی شبکهی عمیق میتواند فقط یک لایهی ورودی داشته باشد و سپس به دو شبکهی مجزا تقسیم شود. در انتهای دیگر، وظایف میتوانند برای تمامی پردازشهای خود از یک شبکه استفاده کنند و تنها در مرحلهی خروجی تقسیم شوند. معماری شبکه میتواند یکی از دهها نوع میانی باشد که برخی از مراحل در شبکه مشترک و برخی دیگر جدا باشند.

همانطور که انتظار میرفت، شبکههایی که بعد از لایهی ورودی مسیرهای اختصاصی داشتند، از شبکههایی که کل مسیرهای آنها مشترک بود، عملکرد بهتری داشتند. اگرچه یک شبکهی ترکیبی (مثلا شبکهای با ۷ لایه مشترک پس از مرحلهی ورودی و سپس دو شبکهی جداگانه که هریک ۵ لایه جدا داشتند) تقریبا به خوبی شبکههای کاملا جداگانه عملکرد میکرد. مکدرموت و همکارانش شبکهی ترکیبی را بهعنوان شبکهای انتخاب کردند که با کمترین منابع محاسباتی، بهترین عملکرد را داشت.

انواع مختلف طراحی شبکهها برای انجام چند وظیفه

عملکرد این شبکه با عملکرد انسان همخوانی داشت. این نتایج همچنین با نتایج قبلی پژوهشگران مطابقت داشت که نشان میداد قشر شنوایی غیر اولیه دارای مناطق مجزایی برای پردازش موسیقی و گفتار است. در آزمایشی که در سال ۲۰۱۸ منتشر شد، این مدل، فعالیت مغز را در انسان پیشبینی کرد: لایههای میانی، پاسخهای قشر شنوایی اولیه و لایههای عمیقتر پاسخ مناطق بالاتر قشر شنوایی را پیشبینی میکردند. این پیشبینیها از پیشبینیهای مدلهایی که مبتنیبر یادگیری عمیق نبودند، بهتر بود.

نانسی کانویشر، عصبشناس مؤسسه فناوری ماساچوست، از مدلهای مکدرموت الهام گرفت. پژوهشهای گذشتهی کانویشر نشان میداد منطقهای از قشر گیجگاهی تحتانی مغز بهنام منطقه دوکیشکل چهره (FFA) برای شناسایی چهرهها تخصص پیدا کرده است. فعالیت این منطقه از مغز هنگامی که انسانها به تصاویر چهره خیره میشدند، بسیار بیشتر از زمانی بود که به تصاویر اشیاء نگاه میکردند. چرا مغز پردازش چهرهها را از پردازش اشیاء دیگر جدا میکند؟

معمولا، پاسخ دادن به چنین سوالاتی برای علوم اعصاب دشوار بوده است. بنابراین، کانویشر و همکارانش برای نزدیک شدن به پاسخ این سؤال به شبکههای عمیق روی آوردند. آنها از نسخهی عمیقتری از AlexNet بهنام VGG استفاده کردند و دو شبکهی عمیق جداگانه را برای انجام وظایف خاص آموزش دادند: تشخیص چهرهها و تشخیص اشیاء. شبکهی عمیق آموزشدیده برای تشخیص چهرهها در تشخیص اشیاء عملکرد خوبی نداشت و بالعکس. پژوهشگران در مرحلهی بعد، شبکهی واحدی را برای انجام هر دو وظیفه آموزش دادند. آنها دریافتند که شبکه بهطور درونی خود را سازماندهی کرده است تا پردازش چهرهها و اشیاء را در مراحل بعدی شبکه از هم تفکیک کند. این نتایج با نحوهی سازماندهی سیستم بینایی انسان سازگار است.

لایههای بو

سال گذشته، دانشمند عصبشناسی بهنام رابرت یانگ و همکارانش از دانشگاه کلمبیا، شبکهی عصبی عمیقی را برای مدلسازی سیستم بویایی مگس میوه طراحی کردند. سیستم بویایی مگس میوه بهخوبی شناسایی شده است. اولین لایه از پردازش بو شامل نورونهای حسی بویایی میشود که هریک از آنها فقط یکی از حدود ۵۰ نوع گیرندهی بو را بیان میکنند. نورونهای حسی از نوع یکسان (بهطور متوسط حدود ۱۰ عدد از آنها) در لایهی بعدی به یک خوشهی عصبی واحد میرسند. در هر طرف از مغز در این لایه، حدود ۵۰ مورد از این خوشههای عصبی وجود دارد؛ بنابراین، این یک انتقال یکبهیک را بین انواع نورونهای حسی و خوشههای عصبی متناظر ایجاد میکند. خوشههای عصبی در لایهی بعدی که لایه کنیون نام دارد، چندین ارتباط تصادفی با نورونها دارند. لایهی کنیون حدود ۲۵۰۰ نورون دارد که هریک از آنها حدود ۷ ورودی دریافت میکنند. لایهی نهایی که از حدود ۲۰ نورون تشکیل شده است، خروجی را فراهم میکند که مگس از آن برای هدایت اعمال مرتبط با بو استفاده میکند.

یانگ و همکارانش برای اینکه ببینند آیا میتوانند یک مدل محاسباتی برای تقلید از این فرایند طراحی کنند، ابتدا مجموعه دادهای را برای تقلید از بوها ایجاد کردند که نورونها را به شیوهای متفاوت از تصویر فعال میکرد. اگر دو تصویر گربه را روی هم قرار دهید و آنها را پیکسل به پیکسل اضافه کنید، تصویر حاصل ممکن است مانند گربه به نظر نرسد؛ اما اگر بوی دو سیب را با هم مخلوط کنید، احتمالا هنوز بویی مانند سیب میدهد. یانگ و گروهش برای طراحی وظیفهی بویایی این ایده را دنبال کردند.

پژوهشگران شبکه عمیق خود را با چهار لایه ساختند: سه لایه که لایههای پردازشکننده را در مگس میوه مدلسازی میکرد و یک لایهی خروجی. هنگامی که آنها این شبکه را برای طبقهبندی بوهای شبیهسازیشده آموزش دادند، متوجه شدند شبکه به همان شکلی که در مغز مگس میوه دیده میشود، ارتباطاتی ایجاد کرد: یک انتقال یکبهیک از لایهی ۱ به لایهی ۲ و سپس یک مسیردهی پراکنده و تصادفی (۷ به ۱) از لایه ۲ به لایه ۳. این تشابه نشان میدهد که هم تکامل و هم شبکهی عمیق به راهحل بهینهی یکسانی رسیدهاند.

شبکههای عمیق جعبههای سیاه نیستند

شبکههای یادگیری عمیق اغلب به دلیل عدم قابلیت تعمیم به دادههایی که از مجموعه دادههای آموزش فاصلهی زیادی دارند، مورد تمسخر قرار میگیرند. آنها همچنین به دلیل عملکرد مشابه جعبه سیاه، بدنام هستند. توضیح تصمیمات شبکه عمیق با بررسی پارامتریهای سازنده آن، غیر ممکن است.

سال گذشته، تیم دیکارلو نتایجی را منتشر کرد که به موضوع ابهام و عدم قابلیت تعمیم شبکههای عمیق میپرداخت. پژوهشگران از نسخهای از AlexNet برای مدلسازی جریان بصری شکمی ماکاکها استفاده کردند و تشابهات واحدهای نورون مصنوعی و مکانهای عصبی را در منطقهی V4 میمونها کشف کردند. آنها سپس با استفاده از مدل محاسباتی تصاویری ایجاد کردند که طبق پیشبینی آنها، باعث افزایش غیر عادی در فعالیت نورونها در میمونها میشد. در یکی از آزمایشها، وقتی این تصاویر غیر طبیعی به میمونها نشان داده شد، فعالیت عصبی در مکانهای عصبی تا ۶۸ درصد بیش از سطوح عادی افزایش یافت. در آزمایش دیگر، آن تصاویر فعالیت یک نورون را افزایش میداد و فعالیت نورونهای نزدیک را سرکوب میکرد. هر دو نتیجه را مدل شبکه عصبی پیشبینی میکرد. ازنظر پژوهشگران، این نتایج نشان میدهد شبکههای عمیق را میتوان درمواردی به مغز تعمیم داد.

البته همگرایی در ساختار و عملکرد بین شبکههای عمیق و مغز لزوما به این معنا نیست که هردو به یک شیوه عمل میکنند. از برخی جهات عملکرد آنها بهوضوح با هم فرق دارد؛ اما ممکن است شباهتهای کافی میان دو سیستم وجود داشته باشد که نشان دهد هر دو از اصول کلی یکسانی پیروی میکنند.

محدودیتهای مدلها

مکدرموت ارزش درمانی بالقوهای در مطالعات شبکه عمیق میبیند. امروزه وقتی افراد شنوایی خود را از دست میدهند، معمولا بهعلت تغییراتی است که در گوش رخ میدهد. سیستم شنوایی مغز باید با ورودی ناقص کنار آید. مکدرموت میگوید: «اگر بتوانیم به کمک این مدلها عملکرد سیستم شنوایی را بهتر بشناسیم، روشهای بهتری برای کمک به شنوایی این افراد پیدا خواهیم کرد.» بااینحال، مکدرموت در مورد محدودیتهای شبکههای عمیق محتاط و در این مورد به مطالعه مشغول است. درزمینهی بررسی این محدودیتها، پژوهشگران در آزمایشگاه مکدرموت روی «متامرها» تمرکز کردند که از نظر فیزیکی، سیگنالهای ورودی متمایزی هستند که در یک سیستم، نمایش یکسانی تولید میکنند. برای مثال، دو متامر صوتی اشکال موجی متفاوتی دارند اما برای انسان یکسان به نظر میرسند.

پژوهشگران با استفاده از مدل شبکه عمیق از سیستم شنوایی، متامرهایی از سیگنالهای شنوایی طبیعی را طراحی کردند. این متامرها مراحل متفاوتی از شبکهی عصبی را به همان روش کلیپهای صوتی، فعال میکردند. اگر شبکهی عصبی، سیستم شنوایی انسان را بهدرستی مدلسازی میکرد، باید متامرها مانند هم به نظر میرسیدند؛ اما چنین چیزی اتفاق نیفتاد و انسانها متامرها را از هم تشخیص میدادند.

در دانشگاه استنفورد، یامینز درحال بررسی تفاوت مدلها و مغز است. بهعنوان مثال، بسیاری از مدلها برای آموزش به حجم عظیمی از دادههای برچسبخورده نیاز دارند؛ درحالیکه مغز میتواند بدون هیچ زحمتی با استفاده از یک مثال یاد بگیرد. تلاشهایی برای ایجاد شبکههای یادگیری عمیق بدون نظارت در حال انجام است که بتوانند با همین کارآیی یاد بگیرند.

جاش ﺗﺎﻧﻨﺒﺎﺋﻮم، عصبشناس مؤسسه فناوری ماساچوست، میگوید: «درحالیکه تمامی این مدلهای شبکه عمیق از مراحل واقعی پیشرفت هستند، آنها غالبا وظیفهی طبقهبندی را انجام میدهند.» این درحالی است که مغز ما کار بسیار بیشتری انجام میدهد. سیستم بینایی ما میتواند هندسهی سطوح و ساختار سهبعدی یک صحنه را درک کند و میتواند در مورد عوامل پشتصحنهای که موجب اتفاقی شدهاند، استدلال کند. برای مثال مغز در زمان واقعی میتواند نتیجهگیری کند که یک درخت به این خاطر که اتومبیلی از پیش آن عبور کرده است، ناپدید شده است.

برای درک این توانایی مغز گروهی از پژوهشگران مدلی با نام مدل گرافیکی معکوس ساختند. این مدل کار خود را با پارامترهای توصیفکنندهی چهرهای آغاز میکند که باید روی پسزمینه نشان داده شود؛ مانند شکل، بافت، جهت نور، موقعیت سر و موارد دیگر. یک برنامه گرافیکی کامپیوتری بهنام «مدل مولد» صحنهای سهبعدی از این پارامترها ایجاد میکند و پس از چندین مرحله پردازش، تصویری دو بعدی از آن صحنه ایجاد میکند که از جهت خاصی دیده میشود.

پژوهشگران با استفاده از دادههای سهبعدی و دوبعدی حاصل از مدل مولد، نسخهی اصلاحشدهای از AlexNet را برای پیشبینی پارامترهای احتمالی یک صحنهی سهبعدی از روی یک تصویر دوبعدی ناآشنا، آموزش دادند. ﺗﺎﻧﻨﺒﺎﺋﻮم گفت: «سیستم یاد میگیرد از اثر بهعلت پی ببرد و از تصویر دوبعدی به تصویر سهبعدی که آن را تولید کرده است، برسد.» این تیم مدل خود را با تأیید پیشبینیهای آن در مورد فعالیت در قشر گیجگاهی تحتانی میمونهای رزوس آزمایش کرد. آنها ۱۷۵ تصویر را به ماکاکها نشان دادند که ۲۵ نفر را در ۷ موقعیت نشان میدادند و سیگنالهای عصبی حاصل از مناطق مربوط به تشخیص چهره در مغز را ثبت کردند.

پژوهشگران همچنین تصاویر را به شبکه یادگیری عمیق خود نشان دادند. در شبکه، فعالسازی نورونهای مصنوعی در لایهی اول نشاندهندهی تصویر دوبعدی و فعالسازی در لایهی دوم نشاندهندهی پارامترهای سهبعدی است. پژوهشگران متوجه شدند که سه لایهی آخر شبکه بهطور چشمگیری با سه لایهی آخر شبکه پردازش چهره در ماکاکها مطابقت دارد. این امر نشان میدهد که مغز نهتنها برای تشخیص و تعیین ویژگی اشیاء بلکه برای استنباط ساختارهای سببی درون صحنهها، از ترکیب مدلهای شناخت و مولد استفاده میکند و تمامی اینها در یک لحظه اتفاق میافتد. ﺗﺎﻧﻨﺒﺎﺋﻮم تصدیق میکند که مدل آنها اثبات نمیکند مغز به این شیوه کار میکند؛ اما به نظر او راهی برای درک بهتر عملکرد مغز فراهم میآورد.

نظرات