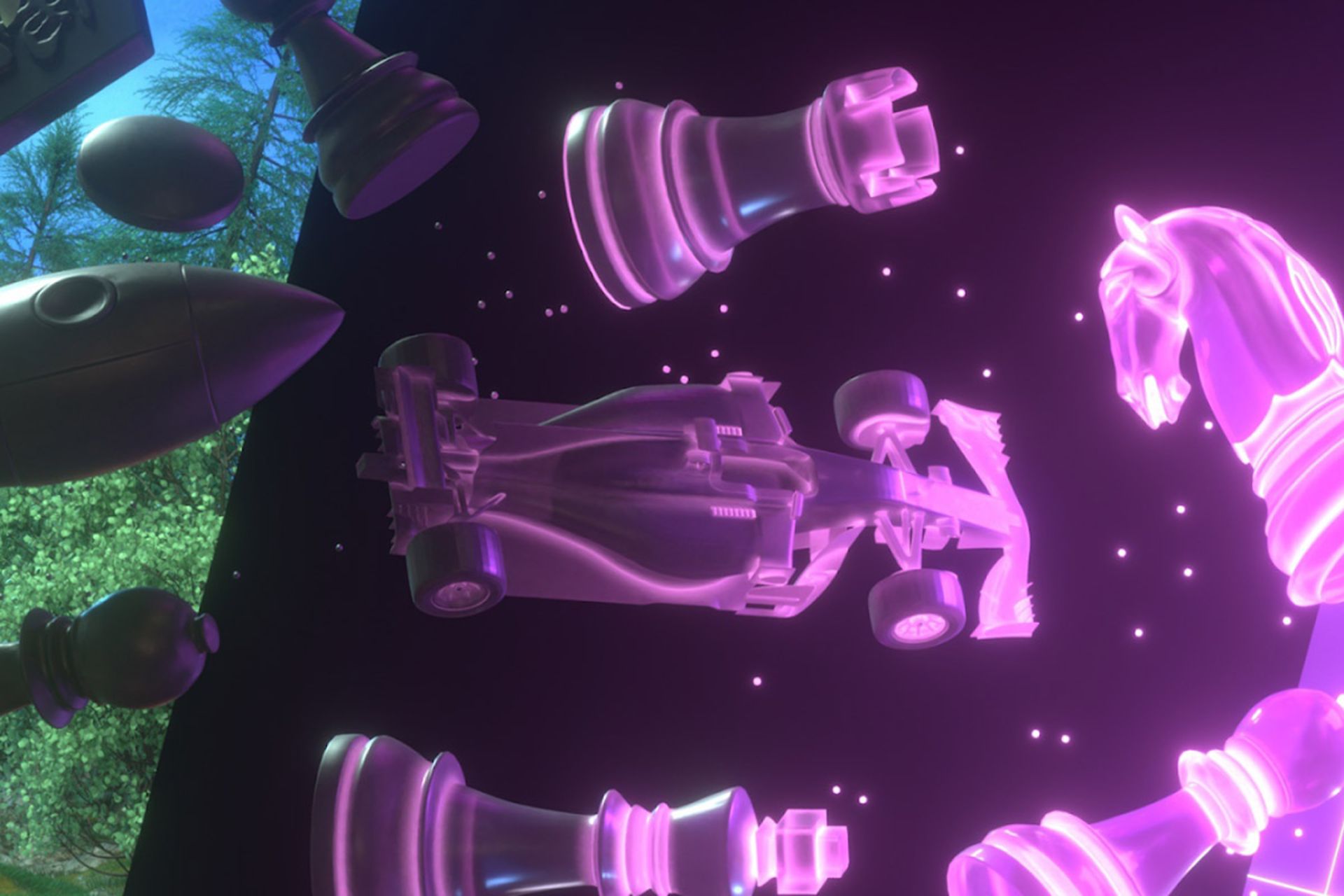

MuZero؛ هوش مصنوعی گوگل با توانایی یادگیری شطرنج و پک من

هوش مصنوعی برای اولینبار در بازی شطرنج بر انسان غلبه کرد. این بازی دارای بیشمار ترکیب احتمالی اما کاملا رامشدنی است؛ زیرا با مجموعهای از قوانین محدود میشود. الگویتم شطرنج میتواند به دانش کاملی از وضعیت بازی برسد و تمام حرکتهای احتمالی رقیب را حدس بزند. وضعیت بازی را هم میتوان با نگاه کردن به صفحه ارزیابی کرد.

اما بسیاری از بازیهای دیگر بهسادگی شطرنج نیستند. اگر تجربهی بازی پک من داشته باشید، متوجه میشوید محاسبهی حرکت ایدهآل با توجه به شکل هزارتو، موقعیت ارواح، موقعیت نواحی مورد نظر برای پاکسازی، دسترسی به جانها و در نهایت دستیابی به بهترین نقشه در صورت اجرای حرکتی غیر منتظره، میتواند نتایج فاجعهباری بهدنبال داشته باشد. تاکنون چندین هوش مصنوعی برای اجرای این بازی ساخته شده؛ اما روش آنها با پیروزی در بازی شطرنج یا Go کاملا متفاوت است. حالا بخش دیپمایند گوگل در مقالهای به توصیف ساختار نوعی هوش مصنوعی میپردازد که قادر است هر دو بازی شطرنج و پک من را اجرا کند و به نتایج خوبی برسد.

اعمال درختها

الگوریتمهای شطرنج و Go از روش درختی استفاده میکنند؛ الگوریتم در این روش به بررسی تمام شاخههای برآمده از عملیات مختلف میپردازد. این روش از نظر محاسباتی پرهزینه است و الگوریتم باید قوانین بازی را بداند تا بتواند وضعیتهای فعلی بازی را با وضعیتهای آیندهی آن تطبیق بدهد.

بازیهای دیگر نیاز به الگوریتمی دارند که اهمیتی به وضعیت بازی نمیدهد. در این بازیها الگوریتم صرفا آنچه میبیند (برای مثال موقعیت پیکسلهای صفحهی نمایش) ارزیابی و سپس براساس مشاهدات عمل میکند. هیچ مدل داخلی از وضعیت بازی وجود ندارد و فرایند یادگیری شامل محاسبهی واکنش مناسب براساس اطلاعات معین است.

بخشی از سیستم جدید دیپمایند به نام MuZero تا اندازهای مشابه هوش مصنوعی آلفازیرو است که خود را در بازیهای قانونمحوری مثل شطرنج و Go آموزش میدهد؛ با این تفاوت که موزیرو انعطاف بیشتری از آلفازیرو دارد و از قابلیت یادگیری تقویتی مبتنی بر مدل برخوردار است. در چنین سیستمی نرمافزار از آنچه در بازی میبیند برای ساخت مدل داخلی وضعیت بازی استفاده میکند. به این ترتیب هیچ درک پیشساختهای وجود ندارد بلکه هوش مصنوعی در کاربرد اطلاعات از انعطاف بالایی برخوردار است. در یادگیری تقویتی، هوش مصنوعی تشخیص میدهد چه زمانی از اطلاعات مدل برای تصمیمگیری استفاده کند.

پیشبینیها

هدف مدل بهکاررفته در موزیرو، پیشبینی حرکات، از جمله بهترین حرکت ممکن براساس وضعیت موجود و وضعیت بازی در نتیجهی حرکت است. پیشبینی معمولا براساس مدل داخلی وضعیتهای بازی اجرا میشود نه براساس نمایش بصری واقعی از بازی مثل موقعیت مهرههای شطرنج.

بهطور کلی موزیرو به این صورت عمل میکند: سه ارزیابی را بهصورت موازی اجرا میکند: یکی از آنها حرکت بعدی را براساس مدل فعلی از وضعیت بازی انتخاب میکند؛ ارزیابی دوم به پیشبینی وضعیت فعلی نتایج و پاداش فوری حاصل از تفاوت آنها میپردازد؛ سومین ارزیابی تجربهی قبلی را برای تصمیمگیری در نظر میگیرد. هر کدام از این ارزیابیها نتیجهی آموزش است و بر حداقلسازی خطای پیشبینیها و اتفاقهای واقعی بازی تمرکز دارد.

موزیرو علاوه بر مهارت در شطرنج و Go، در بازیهای آتاری هم به برتری رسیده است؛ هدفی که تا قبل از موزیرو به روش متفاوت هوش مصنوعی نیاز داشت. موزیرو در مقایسه با الگوریتم قبلی که از مدل داخلی استفاده نمیکند، از میان ۵۷ بازی تستشده در ۴۲ بازی امتیاز بالاتر از متوسط کسب کرد. در نتیجه با وجود برخی مشکلات، هم در بازیهای رقابتی موفق است هم در بازیهای قانونمحوری مثل شطرنج و Go. بهطور کلی موزیرو نشاندهندهی پیچیدگی فزایندهی هوش مصنوعی است. سالهای گذشته هوش مصنوعی صرفا برای یک وظیفه مثل تشخیص گربهای در عکس آموزش داده میشد؛ اما امروزه میتوان ابعاد مختلف هوش مصنوعی را بهصورت همزمان آموزش داد. در اینجا موزیرو قادر به ایجاد مدلی است که توانایی انتخاب، حرکت و پیشبینی پاداشهای آینده را دارد.

نظرات