پلتفرم Maxine؛ راه جدید انویدیا برای ایجاد تغییر در تماسهای ویدئویی

ماه گذشته، انویدیا پلتفرم جدیدی با نام Maxine معرفی کرد که از هوش مصنوعی (AI) برای افزایش کارایی نرمافزارهای ویدئوکنفرانس استفاده میکند. این نرمافزار با ایجاد شبکهی عصبی فشرده سعی میکند تصویری فشرده از چهرهی افراد ایجاد کند. این تصویر میتواند ازطریق شبکه ارسال شود؛ یعنی به جایی که شبکهی عصبی دوم تصویر اصلی را همراه تغییرات مفید بازسازی میکند.

انویدیا معتقد است استفاده از این روش میتواند درمقایسهبا تکنیکهای متداول فشردهسازی، نیاز به پهنای باند نرمافزارهای کنفرانس ویدئویی را حداکثر ۱۰ برابر کاهش و روش نمایش چهرهی افراد را هم تغییر دهد. بهعنوان مثال، اگر بهنظر برسد فردی بهدلیل موقعیت دوربین خود در خارج از مرکز آن قرار دارد، نرمافزار میتواند صورت او را بچرخاند تا مستقیما مشاهدهشدنی باشد. این پایان کار نیست و نرمافزار میتواند چهرهی واقعی کاربر را با آواتار متحرک هم جایگزین کند.

پلتفرم Maxine را میتوان کیت توسعهی نرمافزار توصیف کرد و آن را کالای مصرفی نباید بهحساب آورد. انویدیا امیدوار است توسعهدهندگان نرمافزارهای شخص ثالث بتوانند از Maxine برای بهبود نرمافزارهای کنفرانس ویدئویی استفاده کنند. گفتنی است نرمافزار با محدودیت مهمی همراه است. برای مثال، دستگاه دریافتکنندهی جریان ویدئویی به پردازندهی گرافیکی انویدیا با فناوری هسته تنسور (Tensor) احتیاج دارد. انویدیا بهمنظور پشتیبانی از دستگاههای فاقد کارت گرافیک مناسب توصیه میکند فریمهای ویدئویی در فضای ابری تولید شوند؛ البته عملکرد مثبت و کامل این روش را هم نمیتوان تضمین کرد.

اگر بخواهیم از هزینهی مربوط به Maxine صرفنظر کنیم، بهنظر میرسد این پلتفرم در آینده برای سرویسهای پخش ویدئو ارزشمند خواهد بود. در مدت زمان نهچندان دور، بیشتر دستگاههای محاسباتی به قدرتی خواهند رسید که میتوانند با استفاده از شبکههای عصبی Maxine و سایر پلتفرمهای مشابه، در زمان واقعی محتواهای ویدئویی تولید کنند.

رقابت شبکههای عصبی

پلتفرم Maxine براساس تکنیک یادگیری ماشین ساخته شده است که اصطلاحا شبکههای مولد تخاصمی (Generative Adversarial Network) نامیده میشود. شبکههای مولد تخاصمی شبکهای عصبی بهحساب میآید و درحقیقت توابع پیچیده ریاضی است که ورودیهای عددی را دریافت و خروجیهای عددی را تولید میکند. معمولا ورودی شبکه عصبی در برنامههای بصری نمایش پیکسلبهپیکسل تصویر است. بهعنوان مثال، یکی از نمونههای مشهور این شبکههای عصبی سیستمی بود که در آن، از تصاویر بهعنوان ورودیها استفاده شد و شبکه تصویر خروجی را با کنارگذاشتن تعداد بسیاری از دستهها، فقط به هزار دسته ازجمله سگهایی با نژاد دالمیشن و قارچها محدود کرد.

شبکههای عصبی هزاران و گاه میلیونها پارامتر تنظیمشدنی دارند. جالب است بدانید این شبکه با ارزیابی عملکرد خود دربرابر دادههای دنیای واقعی آموزش میبیند. بهعنوان مثال، این شبکه یک ورودی از دنیای واقعی (همانند تصویر سگ) را نمایش میدهد که طبقهبندی صحیح آن برای نرمافزار آموزش شناخته شده است. سپس نرمافزار آموزشی از تکنیکی با نام Back-Propagation برای بهینهسازی پارامترهای شبکه استفاده خواهد کرد. مقادیری که شبکه را بهسوی پاسخ صحیح هدایت کردهاند، ارتقا داده خواهند شد و مقادیری که به دستیابی پاسخ اشتباه کمک کردهاند، مجددا بازخوانی میشوند. پس از تکرار این فرایند روی هزاران یا میلیونها نمونه، امکان دارد شبکه برای نمونههای آموزشدیده کاملا کارآمد باشد.

نرمافزار آموزش باید پاسخ صحیح را برای هر ورودی بداند؛ بههمیندلیل، پروژههای کلاسیک یادگیری ماشین معمولا مردم را وادار میکردند تا هزاران مثال را بهصورت دستی برچسبگذاری کنند. درصورتیکه روشی برای تولید خودکار دادههای آموزشی وجود داشته باشد، میتوان فرایند آموزش را تا حد زیادی سریعتر کرد. شبکهی مولد تخاصمی (GAN) را میتوان روش هوشمندانهی آموزش شبکهی عصبی آن هم بدون نیاز به انسان برای برچسبگذاری دانست.

همانطورکه از نام این روش هم برمیآید، GAN درحقیقت دو شبکه است که با یکدیگر در حال رقابت هستند. شبکهی اول را باید مولدی دانست که دادههای تصادفی را بهعنوان ورودی دریافت و سعی میکند تصویری واقعگرایانه ایجاد کند. شبکهی دوم را میتوان تفکیککنندهای دانست که از یک تصویر استفاده و سعی میکند واقعی یا جعلی بودن تصویر ایجادشدهی شبکه اول را تشخیص دهد. هر دو شبکه بهصورت همزمان با برنامهی آموزشی اجرا و نتیجهی هر شبکه برای آموزش شبکهی دیگر استفاده میشود:

- از پاسخهای تفکیککننده برای آموزش تولیدکننده استفاده میشود. هنگامیکه تفکیککننده تصاویر ایجادشدهی تولیدکننده را بهاشتباه طبقهبندی کند، بدانمعنا است که کار تولیدکننده در ایجاد تصاویر واقعگرایانه رضایتبخش بوده است؛ بنابراین، پارامترهایی تقویت خواهند شد که به نتیجه ختم میشوند. همچنین، اگر تفکیککننده تصویری را بهعنوان تصویر جعلی شناسایی کند، نقصی برای تولیدکننده بهحساب میآید.

- در همین حال، نرمافزار آموزشی از میان تصاویر واقعی یا تصاویر تولیدی یکی را تصادفی انتخاب خواهد کرد. درصورتیکه تفکیککننده درست تشخیص دهد، موفقیت تلقی میشود و پارامترهای شبکهی تفکیککننده برای نمایش آن بهروزرسانی خواهند شد.

در شروع آموزش، میتوان عملکرد هر دو شبکه را نامطلوب توصیف کرد؛ اما پیشرفت با گذشت زمان رقم خواهد خورد. همانطورکه کیفیت تصاویر تولیدکننده بهبود خواهد یافت، فرایند تفکیککننده بهمنظور شناسایی تصاویر جعلی هم پیچیدهتر میشود. درحقیقت، هرچه تفکیککننده حساستر شود، شبکهی مولد آموزشهای لازم را برای ایجاد تصاویر واقعیتر دریافت میکند و نتایج بهدستآمده میتواند چشمگیر باشد. وبسایت ThisPersonDoesNotExist.com دقیقا همان کاری را انجام میدهد که دربارهاش در حال بحث هستیم. این وبسایت تصاویر واقعگرایانهای از انسانها ایجاد میکند که وجود ندارند.

این وبسایت با شبکهی عصبی مولدی بهنام StyleGAN ساخته شده و جالب آنکه محققان انویدیا آن را راهاندازی کردهاند. در دههی گذشته، ازآنجاکه کارت گرافیکهای انویدیا به یکی از پردازندههای محبوب برای انجام محاسبههای شبکه عصبی تبدیل شدهاند، این شرکت سرمایهگذاری هنگفتی هم برای تحقیقات دانشگاهی در زمینهی تکنیکها و توسعهی شبکه عصبی کرد.

نخستین شبکههای مولد تخاصمی فقط تلاش کردند تصاویر تصادفی واقعگرایانه را در دستهای گسترده همانند چهرههای انسانی تولید کنند. این تصاویر بهعنوان شبکههای مولد تخاصمی بدون قیدوشرط شناخته میشوند. بهتازگی، محققان شبکههایی تولید کردهاند که تصویر یا سایر دادهها را بهعنوان ورودی دریافت و درنهایت تلاش خواهند کرد تصویر خروجی مرتبط را تولید کنند.

گاهی وقتها، الگوریتم آموزش اطلاعات ورودی یکسانی را به تولیدکننده و تفکیککننده ارائه میدهند. در سایر مواقع، عمکرد تلفات تولیدکننده هم ترکیبی از خروجی تفکیککننده با برخی از معیارهای دیگر است که خروجی متناسب با دادههای ورودی را قضاوت میکند. این روش طیف گستردهای از کاربردها را شامل میشود. محققان از شبکهی مولد تخاصمی (GAN) مشروط برای تولید آثار هنری از توصیف متنی، تولید عکس از طرحها، تولید نقشه از تصاویر ماهوارهای، پیشبینی وضعیت افراد در سنین بیشتر و... استفاده میکنند.

تمام اینها، ما را به پلتفرم Maxine شرکت انویدیا بازمیگرداند. با اینکه انویدیا جزئیات کاملی دربارهی روش کار فناوری Maxine ارائه نداده است، در یکی از مقالههای منتشرشده در سال ۲۰۱۹، برخی از الگوریتمهای اساسی تأمین انرژی Maxine توصیف شده است. این مقاله GAN مشروطی را توصیف میکند که فایلی ویدئویی از چهرهی فرد در حال صحبت را درکنار تعدادی تصویر از چهرهی شخص دوم بهعنوان ورودی دریافت میکند. درادامه، تولید ویدئویی از شخص دوم را شاهد خواهید بود که همان حرکتهای انجامشده در فیلم اصلی و متعلق به شخص اول را انجام میدهد.

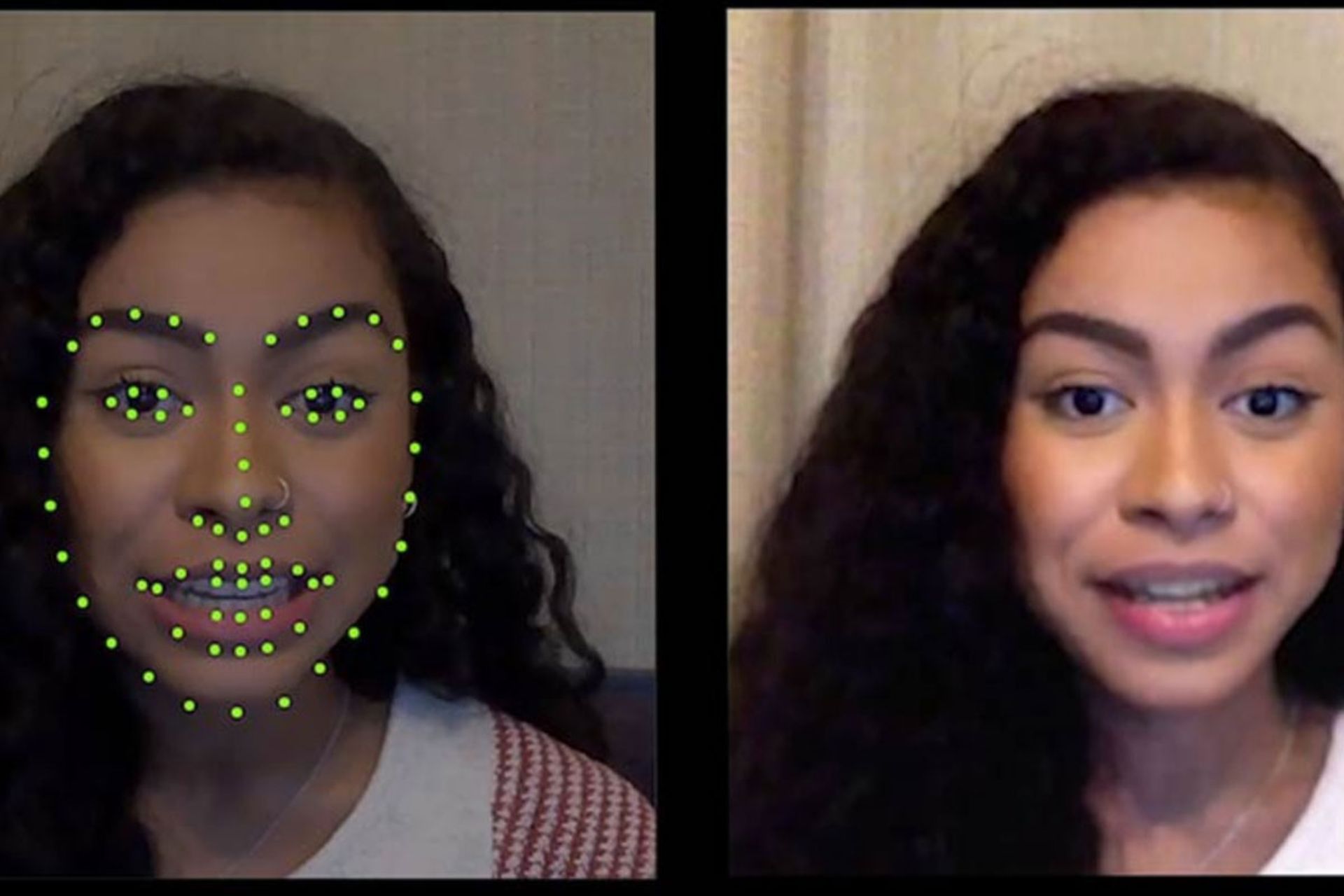

نرمافزار جدید کنفرانس ویدئویی انویدیا از نسخهی اصلاحشدهی این روش استفاده میکند. پلتفرم Maxine بهجای دریافت فایل ویدئویی بهعنوان ورودی، مجموعهای از نکات اصلی استخراجشده از فایل ویدئویی منبع را ازآنِ خود میکند. هدف نقاط دادهای است که محل و حالت چشم، دهان، بینی، ابرو و سایر ویژگیهای صورت را مشخص میکند.

تمام این دادهها میتوانند بهتر از فیلمی معمولی نمایش داده شوند و این بدانمعنا است که میتوان آنها را با حداقل پهنای باند استفادهشده ازطریق شبکه انتقال داد. همچنین، این شبکه یک فریم ویدئویی با وضوح چشمگیر ارسال خواهد کرد تا گیرنده از موضوع باخبر شود. سپس کامپیوتر گیرنده از شبکهی مولد تخاصمی مشروط برای بازسازی چهره شخص مدنظر استفاده خواهد کرد.

یکی از ویژگیهای اصلی شبکهی محققان انویدیا که در سال ۲۰۱۹ توصیف شد، مخصوص یک چهره نبود؛ بلکه شبکهای واحد را میتوان برای تولید فایلهای ویدئویی از افراد مختلف آن هم براساس تصاویر ارائهشده بهعنوان ورودی آموزش داد. مزیت عملی پلتفرم Maxine این است که به آموزش شبکهی جدید بهازای هر کاربر نیازی نیست. توجه کنید که انویدیا میتواند شبکهی تولیدکنندهی از قبل آموزشدیدهای ارائه دهد تا چهرهی هر فردی را ترسیم کند. استفاده از شبکهی آموزشدیده درمقایسهبا شبکهی جدید از این نظر بهتر است که به قدرت محاسباتی کمتری نیاز خواهد بود.

رویکرد و هدف انویدیا را میتوان ویرایش فایل ویدئویی خروجی آن هم با چندین روش ساده عنوان کرد. بهعنوان مثال، یکی از مشکلات رایج در فناوریهای کنفرانس ویدئویی، موقعیت نامناسب دوربین است و بهنظر میرسد که فرد در حال نگاهکردن به محیط اطراف خود است. شبکهی عصبی انویدیا میتواند با چرخاندن نقاط اصلی چهرهی کاربر، مشکل را رفع کند تا در مرکز قرار بگیرند. گفتنی است انویدیا اولین شرکتی نیست که چنین کاری انجام میدهد؛ زیرا اپل مشغول کار روی نسخهی اختصاصی این ویژگی برای FaceTime است. بااینحال، این امکان وجود دارد رویکرد مبتنیبر GAN انویدیا قدرتمندتر باشد و بهجای چشمها، تغییرات را در تمام چهره امکانپذیر کند.

پلتفرم Maxine میتواند سر فرد مدنظر را با شخصیتی متحرک هم جایگزین کند؛ البته این هم قابلیت جدیدی بهحساب نمیآید و اسنپ چند سال پیش این قابلیت را معرفی کرد و درحالحاضر، معمولا در برنامههای چت ویدئویی استفاده میشود. هماکنون سؤالاتی در ذهن مبنیبر تفاوت اقدام انویدیا با سایر پلتفرمها شکل خواهد گرفت و پاسخ روشن است: رویکرد مبتنیبر شبکهی مولد تخاصمی انویدیا میتواند تصاویر واقعبینانهتری فراهم کند که در طیف گستردهای از موقعیتهای مختلف عمل خواهد کرد.

پیادهسازی پلتفرم Maxine در سرور ابری

همانطورکه در قسمتهای قبل هم گفته شد، ماکسین محصول مصرفی نیست؛ بلکه کیت توسعهی نرمافزار برای ساخت نرمافزار کنفرانس ویدئویی است. انویدیا تعدادی از قابلیتهای مختلف را به توسعهدهندگان ارائه و اجازه میدهد تا دربارهی چگونگی ترکیب آنها و ارائهی محصولی کاربردی تصمیمگیری کنند.

حداقل نسخهی اولیهی Maxine با محدودیت مهم یا همان پردازندهی گرافیکی قدرتمندی همراه خواهد بود که اخیرا انویدیا معرفی کرده است. این پلتفرم بهمنظور دریافت جریان ویدئو به پردازندهی گرافیکی قدرتمند انویدیا احتیاج دارد و در بالای هستههای تنسور قرار گرفته است و واحدهای محاسبهگر در کارت گرافیک جدید انویدیا که بهمنظور عملیات یادگیری ماشین بهینهسازی شدهاند. Maxine با محصولات مربوط به کنفرانسهای ویدئویی رقابت خواهد کرد و دلیل آن را میتوان انتظار کاربرانی دانست که تمایل دارند محصول دلخواهشان از سختافزارهای گسترده پشتیبانی کند.

وقتی سؤالاتی برای دریافت پاسخ از نمایندهی شرکت انویدیا مطرح شد، او استدلال کرد که توسعهدهندگان میتوانند پلتفرم Maxine را روی سرور ابری مجهز به سختافزارهای موردنیاز انویدیا اجرا و درادامه فایلهای ویدئویی را در سیستمهای کاربران پخش کنند. با استفاده از پلتفرم ماکسین با روشهای ذکرشده، میتوانید پهنای باند را در لینک ویدئویی کاربر هم ذخیره کنید. دلیل این امر را میتوان نیازنداشتن فناوری Maxine Keypoint Extraction به پردازندهی گرافیکی انویدیا عنوان کرد.

هنوزهم قویترین ویژگی در فروش پلتفرم ماکسین را میتوان نیاز به پهنای باند بسیار کم و چشمگیر آن عنوان کرد؛ البته صرفهجویی در پهنای باند آن هم بهطورکامل زمانی امکانپذیر خواهد بود که ویدئو در دستگاه کاربر تولید شود. برای انجام این کار، پلتفرم ماکسین نیازمند پشتیبانی از دستگاههای بدون پردازندهی گرافیکی است.

هنگامیکه سؤالی مبنیبر پشتیبانی از پردازندههای گرافیکی بهغیر انویدیا از مسئولان شرکت مطرح شد، آنها از اظهارنظر دربارهی محصولات آینده خودداری کردند. درحالحاضر، پلتفرم Maxine در مرحلهی دسترسی اولیه برای توسعه است. درحقیقت، انویدیا اجازهی دسترسی محدود را به گروهی از توسعهدهندگان داده تا بدینترتیب، بتواند مشکلات احتمالی را رفع کند. در آیندهی نزدیک که البته زمان دقیقش مشخص نیست، انویدیا بستر را برای تمام توسعهدهندگان فراهم خواهد کرد.

بعید بهنظر میرسد انویدیا بتواند انحصار این رویکرد را در زمینهی کنفرانس ویدئویی حفظ کند. تاکنون سایر شرکتهای بزرگ فناوری برنامهای برای استفاده از GAN بهمنظور بهبود شرایط کنفرانسهای ویدئویی اعلام نکردهاند؛ اما گوگل و اپل و کوالکام برای تولید تراشههای قدرتمندتر بهمنظور پشتیبانی از یادگیری ماشین در گوشیهای هوشمند در حال تلاش هستند و در این زمینه، گامهای موفقی برداشتهاند. قطعا مهندسان این شرکتها در حال بررسی امکان فشردهسازی فایلهای ویدئویی با استفاده از شبکهی عصبی هستند. اپل باتوجهبه یکپارچهسازی سختافزار و نرمافزار خود، بهویژه در توسعهی نرمافزاری مشابه این پلتفرم، موقعیت مطلوبی دارد.

نظرات