روش IBM در تربیت ۸ بیتی شبکهعصبی، ۴برابر سریعتر با حفظ صحت

شرکت IBM هفته گذشته روشی را معرفی کرد که میتواند کارایی اجرای الگوریتمها هوش مصنوعی را برای کاربرهایی که به دقت بالا نیاز ندارند افزایش دهد. اولین ترفند این شرکت استفاده از تکنیکی است که در آن محاسبات بهصورت ۸ بیتی صورت میگیرد و ترفند دوم تکنیکی استفاده از تراشههای آنالوگ با دقتی برابر با ۸ بیت است. هر دو این تکنیکها در بزرگترین کنفرانس هوش مصنوعی و یادگیری ماشین دنیا با عنوان NeurlPS2018 با جزییات شرح داده شدند.

جفری ولسر معاون و مسئول آزمایشگاه مرکز نحقیقات آلمادن IBM در وبلاگ خود نوشته:

کاربردهای آینده هوش مصنوعی نیاز به پاسخ بسیار سریعتر، حجم محاسبات هوش مصنوعی بالاتر و دادههای چندمنظوره از رشتههای مختلف خواهد بود. برای دستیابی به تمام قابلیتهای هوش مصنوعی، ما سختافزاری جدید با رویکرد ویژه به هوش مصنوعی طراحی کردهایم؛ از شتابدهندهها و سختافزارهای هدفمند برای عملیات حجیم هوش مصنوعی در تراشههای جدید تا تراشههای کوانتومی آینده.یکی از تلاشهای عمدهی IBM در حوزهی هوش مصنوعی، توسعه سختافزارهای ویژهای است که بهجای اجرای وظایف خاص و مشخص هوش مصنوعی، در فعالیتهای عامتر به کار گرفته شوند و به انسانها در حل مشکلات کمک کنند.

حرکت از پردازش اعداد شناور ۱۶ بیتی به ۸ بیتی در نگاه اول شاید یک پسرفت به نظر بیاد، اما بسیاری از عملیات هوش مصنوعی مانند تشخیص گفتار و ترجمه چندان هم به دقت بالای محاسبات نیاز ندارند، در عوض باید بهصورت بلادرنگ و بدون تأخیر انجام شوند. پایین آوردن دقت محاسبات، درها را برای اجرای این عملیات با مصرف توان کمتر و بالابردن کارایی باز میکند. آنطور که ولسر میگوید واحدهای پردازشی اعداد شناور ۱۶ بیت ۴ برابر فضای کمتری نسبت به واحدهای پردازش ۳۲ بیتی اشغال میکنند.

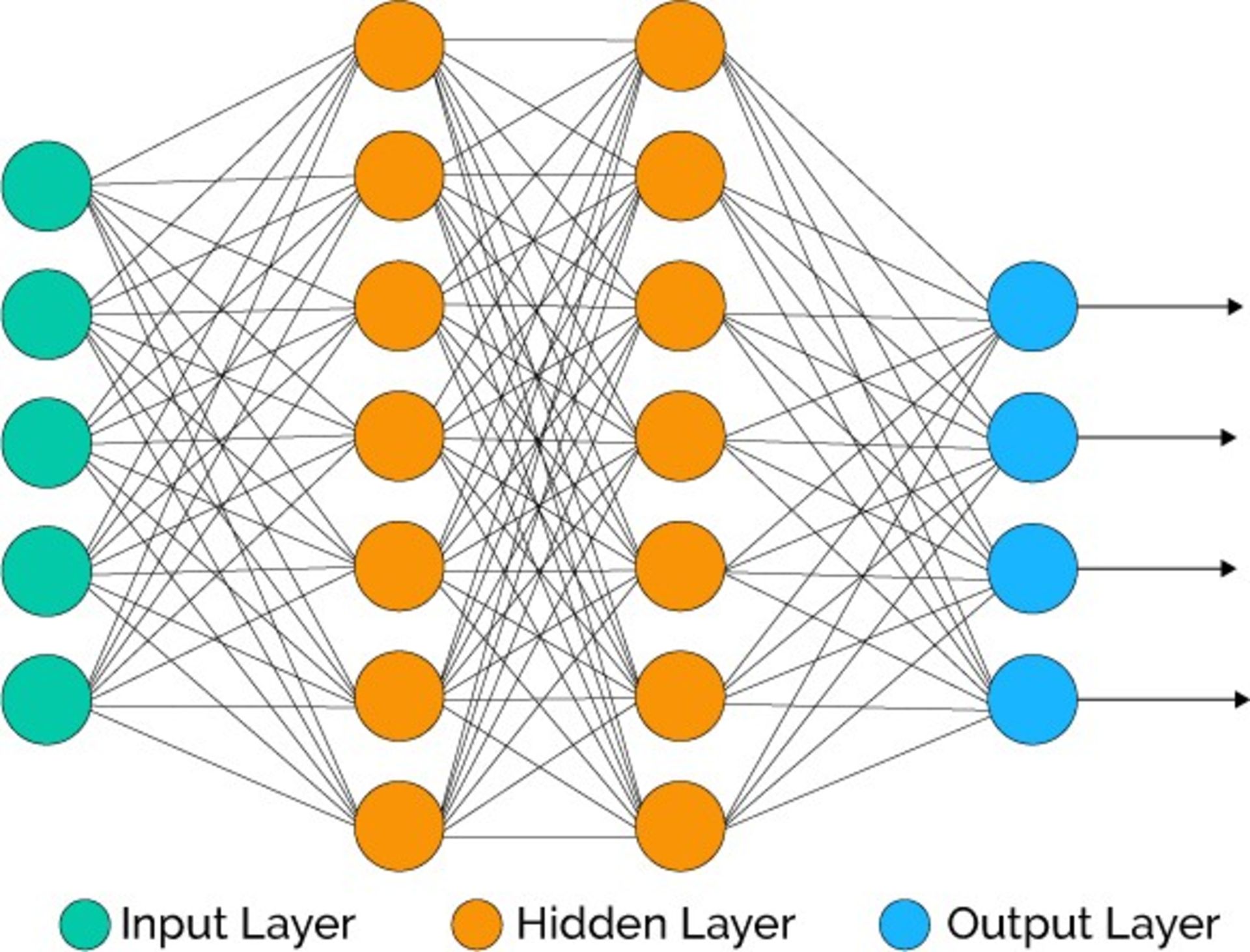

در مقاله علمی با عنوان «تربیت یادگیری عمیق شبکه عصبی با اعداد شناور ۸ بیتی»، محققان IBM توضیح دادهاند که چگونه درکنار کاهش دقت محاسبات از ۳۲ بیت به ۱۶ بیت، صحت محاسبات ۸ بیتی را نیز در عملیاتی نظیر ResNet50، AlexNet و BN50_DNN که در کاربردهایی همچون تشخیص متن، گفتار و تصویر مورد استفاده قرار میگیرد حفظ کردهاند. آنها ادعا کردهاند روش ابداعیشان مدت زمان لازم برای تربیت شبکه را نسبت به عملیات ۱۶ بیتی دو تا چهار مرتبه کاهش داده است.

مقاله علمی دوم –دقت ۸ بیتی در ضرب درون حافظهای با تغییر فاز حافظه- روشی را توضیح میدهد که دقت ذاتی پایین تراشههای آنالوگ هوش مصنوعی را جبران میکند، بهگونهای که عملیات ضرب عددی را با دوبرابر دقت تراشههای دیجیتال ۸ بیتی و ۳۳ بار مصرف توان کمتر انجام میدهد.

هدف این مقاله بازتعریف حافظه از تعریف سنتی ذخیرهسازی داده به تعریف جدید ذخیرهسازی و پردازش داده است. این معماری جدید بهتنهایی میتواند مصرف انرژی را تا ۹۰ درصد کاهش دهد.

رسلر در ادامه نوشته است:

دقت به دست آمده در تحقیقات جدید ما میتواند پردازش درون حافظهای را بهعنوان یک روش با کارایی بالا و مصرف توان اندک در کاربردهایی مانند اینترنت اشیا و پردازش مرزی مطرح کند. همچنین درکنار شتابدهندههای دیجیتال، تراشههای آنالوگ ما بهصورت اختصاصی برای توسعه تربیت شبکههای عصبی و ارایه راهکار برای دادههای تصویری، گفتاری، متنی در حال ظهور طراحی شدهاند.

نظرات