دارپا با همکاری اینتل و دانشگاه جورجیا، سیستم ایمنی یادگیری ماشین توسعه میدهد

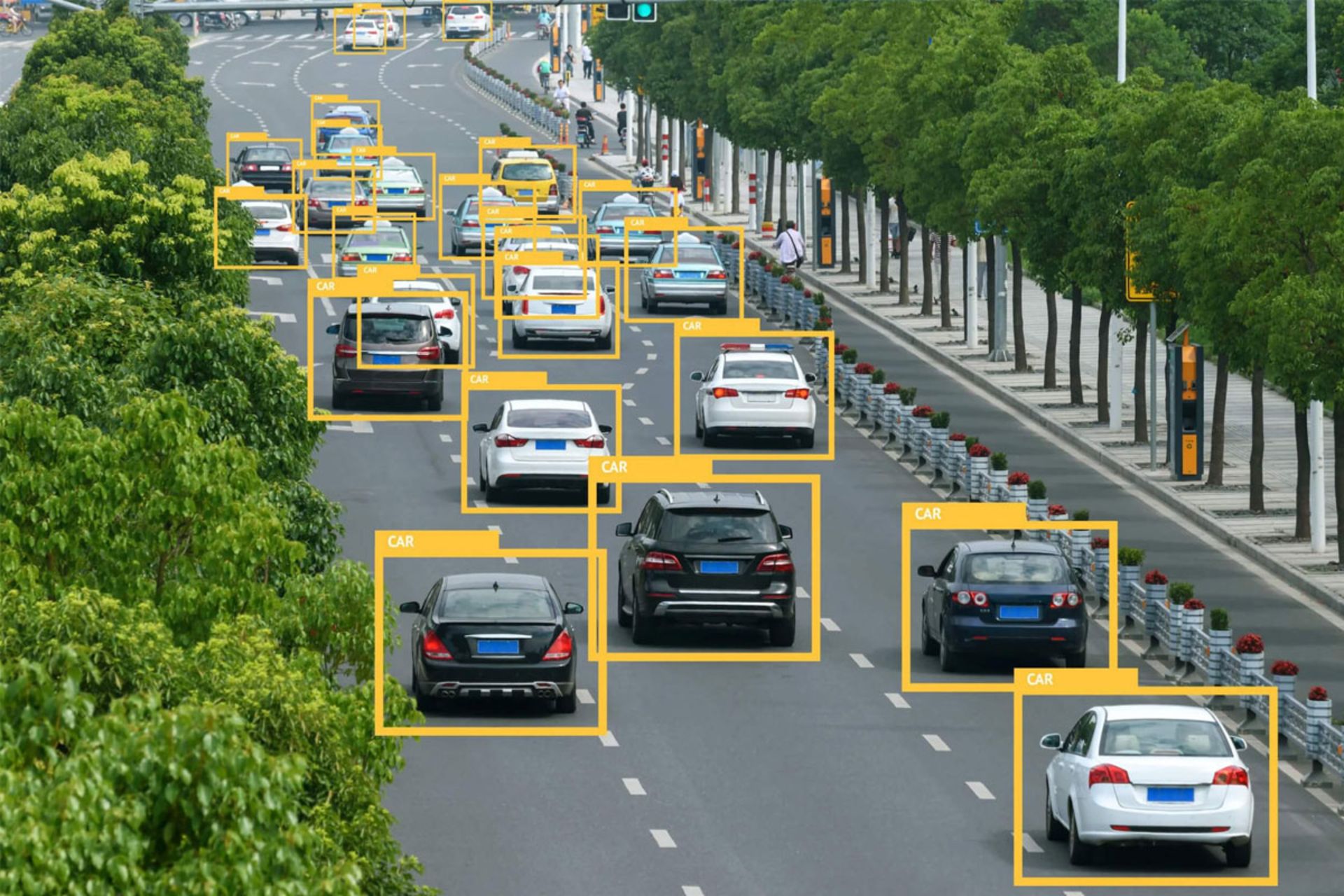

آژانس پروژههای تحقیقات پیشرفتهی دفاعی آمریکا موسوم به دارپا از اینتل و دانشگاه جورجیا تِک خواسته است تحقیقاتی برای دفاع از سیستمهای یادگیری ماشین دربرابر دستکاریها و خرابکاریهای سازماندهیشده انجام دهند. حملههایی که با دستکاری اجسام انجام میشوند، قوهی تشخیص الگوریتمهای یادگیری ماشین را تحتتأثیر قرار میدهند. اگرچه چنین اقدامهایی اکنون بیشتر در محیطهای آزمایشگاهی انجام میشوند، احتمال سوءاستفاده از آنها در سطوح بزرگ وجود دارد.

شرکت امنیتی مکآفی ماه فوریه گزارشی از دستکاری و فریب سیستم یادگیری ماشین منتشر کرد. این گزارش ادعا میکرد محققان توانستهاند در محیط آزمایشگاهی، با جسباندن یک برچسب پنجسانتیمتری روی علامت محدودیت سرعت، سیستم دستیار سرعت یک دستگاه خودرو تسلا مدل S را فریب دهند. درواقع، دستکاری باعث شد خودرو خودران ۸۰ کیلومتربرساعت بیش از سرعت مجاز رانندگی کند. مثالهای متعدد دیگری هم وجود دارند که در آنها، با اقدامهای ساده امکان فریبدادن هوش مصنوعی فراهم شده بود؛ اقدامهایی که تقریبا هر فردی میتواند آنها را انجام دهد.

دارپا خطر بالقوهی دستکاری با هدف فریبدادن هوش مصنوعی را درک میکند و بهدنبال این است بهعنوان سازمان پیشگام، سیستمهایی برای مقابله با حملههای فریب توسعه دهد. این آژانس یک سال پیش برنامهای بهنام GARD مخفف Guaranteeing AI Robustness againsr Deception را شروع کرد. اینتل توافق کرد بهعنوان شریک اصلی تحقیقات در برنامهی چهارسالهی مذکور با جورجیا تِک همکاری کند.

جیسون مارتین، مهندس ارشد اینتل و بازرس برنامهی DRPA GARD، دربارهی پروژهی تحقیقاتی میگوید:

اینتل و جورجیا تِک با هدف افزایش درک جمعی اکوسیستم از آسیبپذیریهای هوش مصنوعی و یادگیری ماشین همکاری میکنند. تلاش میکنیم بهترین راهکارها درمقابل آسیبپذیریها توسعه یابند. همکاری ما با این هدف انجام میشود که با تحقیقات نوآورانه و روشهای تکمیلی، تشخیص اشیاء و توانایی هوش مصنوعی و یادگیری ماشین برای واکنش به اقدامهای خرابکارانه را بهبود دهیم.

مشکل اولیهی راهکارهای کنونی کاهش اثر خرابکاری این است که راهکارها مبتنیبر قوانین و شرایط ایستا هستند. اگر یکی از شرایط شکسته شود، اقدام خرابکارانه موفق خواهد شد. ازآنجاکه برای انجام اقدام خرابکارانه و فریب راههای بیشماری وجود دارند، باید سیستم بهتری طراحی و ساخته شود. اینتل میگوید مرحلهی اول تحقیقات به بهینهسازی قابلیتهای تشخیص اشیای هوش مصنوعی اختصاص دارد. آنها بهدنبال روشی هستند تا هوش مصنوعی در هر دو حالت عکس و ویدئو، انسجام درک فضایی و مادی و معنای پیدا کند.

دکتر هاپا سیگلمن، مدیر برنامهی تحقیقاتی دارپا در دفتر نوآوریهای فناوری، سیستمی توسعه میدهد که تقریبا شبیه به سیستم ایمنی انسان عمل میکند. درواقع، میتوان پروژهی او را نوعی سیستم یادگیری ماشین در دل سیستم یادگیری ماشین دیگر دانست. سیگلمن دربارهی پروژه میگوید:

ایدهی کلی سیستم دفاعی مدنظر ما را میتوان در سیستم ایمنی بدن انسان هم مشاهده کرد؛ سیستمی که پس از تشخیص حمله، بر آن پیروز میشود و مشخصات حمله را بهخاطر میسپارد. درنتیجه در حملههای مشابه آتی، دفاع مشابهی انجام میدهد. درنهایت، باید به این سطح از اطمینان برسیم که سیستم یادگیری ماشین امن است و نمیتوان آن را فریب داد.

با افزایش نفوذ سیستمهای هوش مصنوعی و یادگیری ماشین در زندگی روزمرهی مردم، حفظ ایمنی آنها اهمیت بیشتری پیدا میکند. سیستمهای هوش مصنوعی امروزه بسیاری از وظایف تصمیمگیری انسانها را هم انجام میدهند و درنتیجه، باید ایمنی و مقاومت بسیاری دربرابر حملات متنوع داشته باشند.

نظرات